Llama 4を最小コストで微調整!LoRAとExpert Freezeで実現する業務特化AI構築ガイド

業務に特化したAIモデルを低コストで構築したい、でも大規模言語モデル(LLM)のファインチューニングは専門的で費用がかかりそう…そんな悩みを抱えるビジネスパーソンは多いのではないでしょうか。Meta社が発表した最新のオープンソースモデル「Llama 4」は、その悩みを解決する可能性を秘めています。 [6, 15] 本記事では、初心者でもわかるように、Llama 4の革新的なアーキテクチャ「Mixture of Experts (MoE)」と、最小限の計算資源でモデルを微調整する「LoRA」「Expert Freeze」という技術を組み合わせた、コスト効率の良いAI構築法を丁寧に解説します。

はじめに:なぜ今、Llama 4と効率的な微調整が注目されるのか

近年、AIの性能は飛躍的に向上しましたが、その一方でモデルは巨大化し、自社の業務に合わせてカスタマイズ(ファインチューニング)するには莫大な計算資源とコストが必要という課題がありました。 [22, 23] しかし、Metaが2025年4月に発表した「Llama 4」ファミリーと、パラメータ効率の良い微調整(PEFT)と呼ばれる技術の登場により、状況は大きく変わりつつあります。 [1, 14] これらの技術を組み合わせることで、一般的なGPU環境でも高性能なLLMを自社専用にチューニングすることが現実的になったのです。本記事では、その具体的な手法とメリットを、専門用語を噛み砕きながら解説していきます。

Llama 4 MoEモデルとは?~「専門家の混合」で賢く効率化~

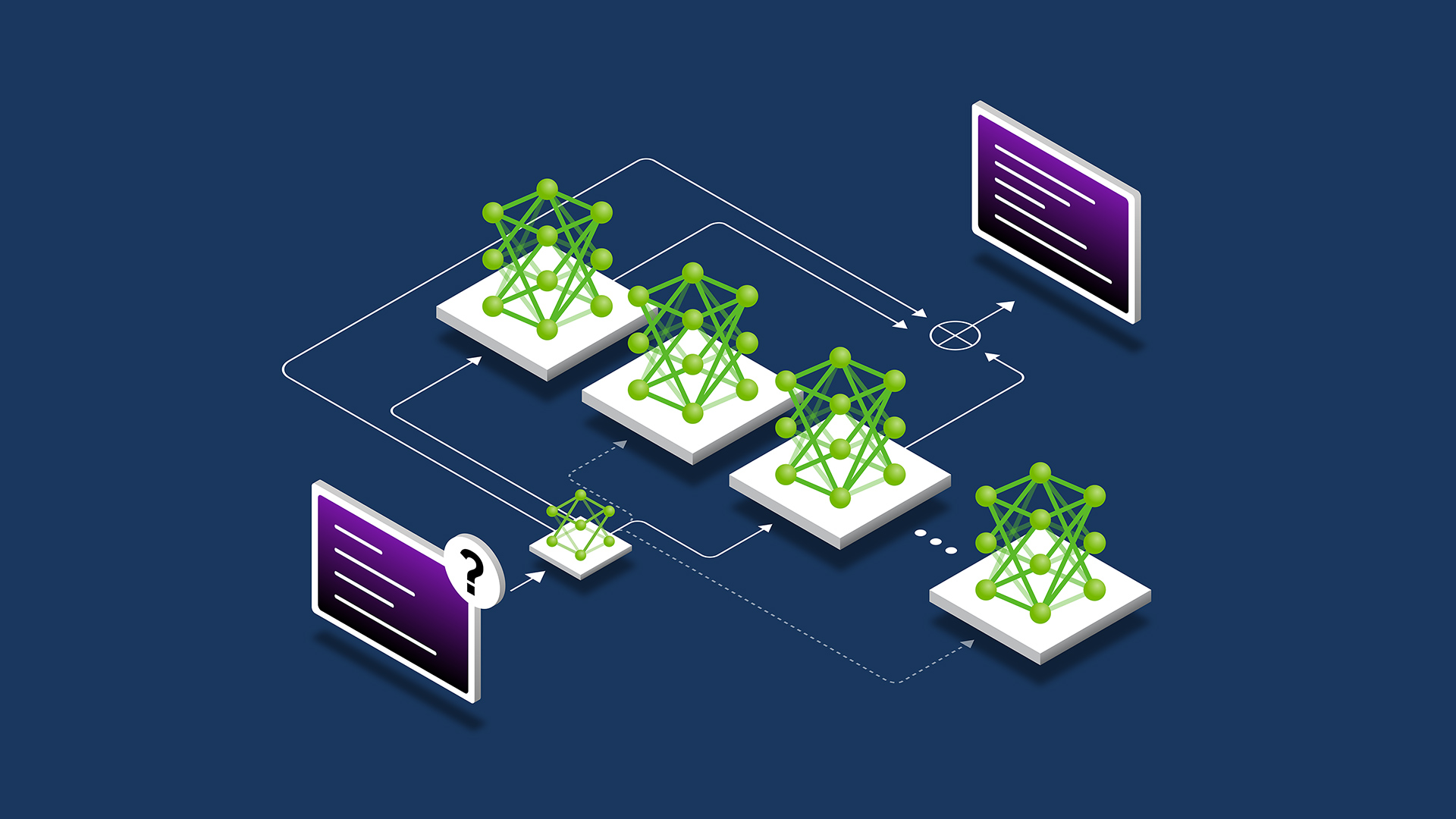

Llama 4の最大の特徴は、「Mixture-of-Experts (MoE)」というアーキテクチャを採用している点です。 [1, 18] これは日本語で「専門家の混合」と訳され、その名の通り、モデルの内部に複数の「専門家ネットワーク(Experts)」を持っているとイメージしてください。 [7]

従来のモデル(密なモデル)が、どんな質問に対しても脳全体(全パラメータ)を使っていたのに対し、MoEモデルは入力された内容に応じて「ゲート(Gate/Router)」と呼ばれる司令塔が、最も得意そうな専門家をいくつか選び出して、その部分だけを動かします。 [1, 7] これにより、モデル全体の規模は非常に大きくても、推論時の計算コストを抑えることが可能になります。 [18] まさに「必要な時に、必要な専門家だけが働く」効率的な仕組みです。

図: MoE(Mixture of Experts)の概念図。ゲート(ルーター)が入力に応じて適切な専門家を選択し、一部の専門家だけが活性化する仕組み。

例えば、Llama 4ファミリーの「Llama 4 Scout」は、16個の専門家を持ち、合計パラメータ数は約1,090億にもなりますが、一度に活性化するパラメータは170億に抑えられています。 [1, 14] このおかげで、単一の高性能GPUでも動作可能なのです。 [1, 14] しかし、これほど巨大なモデルを自社データで微調整しようとすると、全パラメータを更新するのは非現実的です。そこで登場するのが、次に紹介するPEFT(パラメータ効率の良い微調整)というアプローチです。

大規模モデル微調整の課題とPEFTアプローチ

LLMをファインチューニングする際の最大の壁はコストです。 [22, 24] Llama 4 Scoutの全パラメータ(1090億)を微調整しようとすれば、数百GB規模のGPUメモリが必要となり、数百万から数千万円の投資が必要になることもあります。 [23, 24] この「モデルは公開されているのに、大きすぎて手が出せない」というジレンマを解消するのが、PEFT(Parameter-Efficient Fine-Tuning)です。 [32] PEFTは、モデルのごく一部のパラメータだけを新たに学習することで、全パラメータを更新するのと同等の性能向上を目指す手法群の総称です。

LoRAとは?~低ランク行列で賢く差分を学習~

PEFTの中でも特に広く使われているのが「LoRA(Low-Rank Adaptation)」です。 [3, 4] LoRAは、モデルの巨大な重み行列そのものを更新する代わりに、元の重みは凍結(更新しない)したまま、その「差分」だけを学習するための小さな行列を2つ追加します。 [4, 5, 10]

図: LoRAによる学習の概念図。(左)事前学習済みの重みW(青色)は凍結し、小さな低ランク行列A・B(オレンジ色)を追加して重み差分のみを学習する。(右)学習後、WとA・Bを統合できる。

この追加する行列は「低ランク」であるため、学習すべきパラメータの数が劇的に少なくなります。 [12] 結果として、学習に必要なパラメータ数を全体の1%未満、場合によっては0.1%程度にまで削減できるのです。 [10, 29] にもかかわらず、性能は全パラメータをファインチューニングした場合に匹敵することが多く報告されています。 [4, 5] さらに、学習後はこの小さな行列を元のモデルに統合(マージ)できるため、推論時の速度低下がないという大きなメリットもあります。 [5]

Expert Freezeとは?~専門家を「凍結」する戦略~

MoEモデルに特化した効率化戦略が「Expert Freeze」です。これは文字通り、内部にある複数の専門家(エキスパート)層を訓練時に凍結(更新しない)する手法です。 [21, 30] 具体的には、各専門家が持つ膨大なパラメータは事前学習時の知識を保持したままにし、専門家を選び出す「ゲート(ルーター)」や、LoRAで追加した部分だけを学習対象とします。 [21]

この戦略の利点は、学習するパラメータの量がモデル全体の専門家数に依存しなくなることです。 [30] 「巨大な専門家たちには触れず、彼らをどう使うかの司令塔と、微調整用の小さなパーツだけを訓練する」というイメージです。これにより、計算コストとメモリ消費を大幅に削減しつつ、元の専門家が持つ豊富な知識を損なわずにタスクに適応させることができます。 [21, 32]

Llama 4をLoRA+Expert Freezeで微調整する実践手順

それでは、実際にLlama 4モデルを業務データで微調整する具体的な手順を、初心者にも分かりやすく解説します。ここでは、単一のGPUでも実行可能な方法を想定しています。

図: Llama 4の微調整アーキテクチャ。量子化されたベースモデルにLoRAアダプタを適用し、効率的に学習を行う。

1. 環境セットアップと必要ツール

- GPU環境: VRAM(ビデオメモリ)が多いGPUが1枚あると理想的です(例: NVIDIA A100/H100 80GB)。クラウドGPUサービスの利用も有効な選択肢です。

- 主要ライブラリ: Python環境に、Hugging Faceの

transformers,peft,accelerate,bitsandbytesといったライブラリをインストールします。 [27, 31] これらはLLMの操作、PEFTの適用、学習の高速化、メモリ節約のための量子化にそれぞれ使われます。 - モデルの準備: Hugging Face HubからLlama 4のモデルをダウンロードします。この際、4bit量子化という技術を使い、モデルを軽量化してロードするのがメモリを節約する重要なポイントです。 [3, 16]

2. データ準備

ファインチューニングには、自社の業務に特化した「指示(Instruction)」と「理想的な応答」のペアからなるデータセットが必要です。 [29] 例えば、社内の問い合わせ対応であれば「顧客からの質問」と「模範的な回答」のペアを数百~数千件用意します。データはJSONL形式などで準備するのが一般的です。 [27]

3. モデル読み込みとLoRAアダプタの適用

まず、4bit量子化を指定してLlama 4モデルをロードします。次に、PEFTライブラリを使い、LoRAの設定(LoraConfig)を行います。ここで、LoRAを適用する層(Attention層やFFN層など)や、ランク(r)などの重要なパラメータを定義します。 [3, 29] この設定をモデルに適用することで、元のモデルの重みは凍結され、学習対象がLoRAアダプタのみに限定されます。これが実質的にExpert Freeze戦略を実現しています。

4. 学習の実行(ファインチューニング)

Hugging FaceのTrainerまたはSFTTrainerといった便利なツールを使って学習を実行します。 [27, 29] 学習時の設定では、以下の点がポイントになります。

- バッチサイズと勾配蓄積: GPUメモリに一度に乗せられるデータ量(バッチサイズ)は小さく設定し、「勾配蓄積」という技術で実質的なバッチサイズを確保します。

- 学習率: LoRAの学習率は、全パラメータのファインチューニングよりも高めに設定するのが一般的です(例: 1e-4前後)。 [22]

- 混合精度学習:

fp16やbf16といった混合精度学習を有効にすることで、計算速度を向上させ、メモリ使用量を削減します。 [36]

これらの設定により、学習は比較的短時間(データセットの規模によっては数時間)で完了します。 [36, 39]

5. 学習後のモデル統合と検証

学習が完了すると、LoRAアダプタ(数100MB程度の小さなファイル)が生成されます。このアダプタを元のLlama 4モデルにマージ(統合)することで、追加ライブラリが不要な単一のモデルを作成できます。 [29] この統合されたモデルは、推論速度が速く、配布も容易になるというメリットがあります。最後に、業務に関連する質問を投げかけ、期待通りの回答が生成されるかを確認して、ファインチューニングの成功を検証します。

導入メリットとパフォーマンス

この「LoRA + Expert Freeze」手法を導入することで、企業は多くのメリットを得られます。

- 圧倒的なコスト効率: 学習するパラメータを劇的に削減することで、GPUの利用時間やコストを大幅に削減できます。 [10, 24] これまで数百万円規模だったファインチューニングが、より現実的な予算で可能になります。 [23, 25]

- 軽量なハードウェア要件: 4bit量子化と組み合わせることで、従来は複数のGPUが必要だった巨大モデルの学習が、単一のGPUでも可能になります。 [3, 38]

- 高速な開発サイクル: 学習時間が短縮されるため、「調整→評価→改善」のサイクルを高速に回せます。 [37, 39] これにより、ビジネスの変化に迅速に対応できる、より精度の高いモデルを短期間で開発できます。

- 高い性能の維持と推論効率: LoRAはベースモデルの能力を損ないにくく、高い回答精度を維持できます。 [5] また、Llama 4のMoEアーキテクチャがもたらす元々の推論効率の高さもそのまま享受できます。 [18]

- 推論のさらなる高速化(vLLM): 学習済みモデルを「vLLM」のような高性能な推論エンジン上で動かすことで、スループット(単位時間あたりの処理性能)を劇的に向上させることができます。 [2, 17] これにより、多くのユーザーからの同時リクエストにも高速に応答できる、実用的なAIサービスを構築できます。 [16, 17]

おわりに

Llama 4のような最先端のオープンソースLLMと、LoRAやExpert Freezeといった効率的なファインチューニング技術の組み合わせは、AI活用の民主化を大きく前進させます。 [1, 5] これまで専門家や大企業のものであった「AIのカスタマイズ」が、より多くのビジネスパーソンの手に届くようになりました。「大きなモデル全体をいじるのではなく、小さな追加パーツだけを賢く学習させる」というこのアプローチを理解し、活用することで、あなたのビジネスに特化した強力なAIアシスタントを、驚くほど低コストで作り上げることが可能です。ぜひ、この記事をきっかけに、自社専用AIモデルの構築に挑戦してみてはいかがでしょうか。