【初心者向け】Googleの推論特化AIチップ「Ironwood」とは?GPUとの違いやコスト削減効果を徹底解説

近年、ChatGPTをはじめとする生成AIの進化が目覚ましく、私たちのビジネスや生活に大きな変化をもたらしています。しかし、その裏側ではAIを動かすための膨大な計算が必要であり、特にAIが学習した知識を使って実際にタスクをこなす「推論(インファレンス)」のコストが増大し続けています。この課題を解決すべく、Googleは2025年4月に開催されたイベント「Google Cloud Next ’25」で、最新のAI専用チップ「Ironwood」を発表しました。 [3, 4, 14]

この記事では、AIの専門家ではないビジネスパーソンの方にも分かりやすく、以下の点を解説していきます。

- そもそもTPUとは何か、GPUと何が違うのか

- 最新TPU「Ironwood」の驚くべき性能と特徴

- なぜIronwoodはAIの運用コストを劇的に削減できるのか

- クラウド上での具体的な使い方や監視のポイント

AI導入のコスト課題に直面している方や、最新のAIインフラ技術の動向を把握したい方は、ぜひ最後までご覧ください。

AIの「訓練」と「推論」:なぜ今「推論」が重要なのか?

まず、AIの基本的な動作の2つのフェーズ、「訓練(トレーニング)」と「推論(インファレンス)」について簡単に理解しておきましょう。

- 訓練(トレーニング):AIモデルに大量のデータを与えて、賢くさせる「教育」の段階です。例えるなら、膨大な量の教科書や問題集を解かせて、知識を詰め込むイメージです。この段階では、一度に非常に大きな計算パワーが必要になります。

- 推論(インファレンス):訓練が終わったAIモデルが、未知のデータに対して予測や判断を行う「実践」の段階です。私たちがChatGPTに質問を投げかけ、答えが返ってくるのがまさにこの推論です。サービスが続く限り、継続的に計算処理が発生し続けます。

これまではAIモデルを賢くする「訓練」に注目が集まりがちでしたが、AIサービスが普及するにつれて、日々ユーザーのために動き続ける「推論」の計算量が爆発的に増加しています。一説には、大手AI企業の計算リソース予算の半分以上が推論に使われているとも言われています。 [18] この「推論コストの増大」こそが、AIをビジネスで活用する上での大きな課題となっており、現在はAIの「推論の時代」とも呼ばれています。 [3] Googleが発表したIronwoodは、まさにこの推論処理を、より速く、より安く、より効率的に行うために開発された切り札なのです。 [3, 9]

Ironwoodとは?初心者にもわかる基本のキ

それでは、本題の「Ironwood」について見ていきましょう。Ironwoodを理解するために、まずはその土台となる「TPU」について解説します。

TPUとは? GPUとの違い

AIの計算には、これまで主に「GPU(Graphics Processing Unit)」が使われてきました。GPUは元々、パソコンやゲーム機で美しい映像を描画するための半導体チップですが、その高い並列計算能力がAIの計算にも適していたため、広く活用されてきました。 [15]

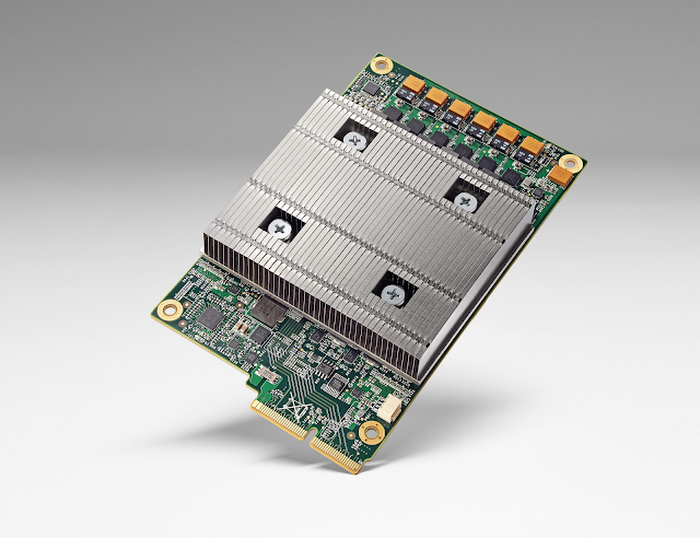

一方、TPU(Tensor Processing Unit)は、GoogleがAIの計算(特にニューラルネットワークで多用される行列演算)を高速化するためだけに開発した、まさに「AI専用チップ」です。 [15, 19] 用途をAIに特化させているため、汎用的なGPUに比べて、AIの計算をより少ない電力で効率的に実行できるという強みがあります。 [11] Google社内では、検索や翻訳、写真解析といったサービスの高速化のために10年以上も前から利用されてきました。 [3]

このTPUの最新世代(第7世代)が「Ironwood」であり、歴代で初めて「推論」に特化して設計されたモデルなのです。 [3, 4]

Ironwoodのすごいところ3つのポイント

Ironwoodは「Google史上最も高性能かつエネルギー効率に優れたTPU」とされており、その特徴は多岐にわたりますが、ビジネスパーソンが押さえておくべきポイントは以下の3つです。

- 推論に最適化された世界最大級の性能:Ironwoodは、特に大規模言語モデル(LLM)や、複数の専門家AIを組み合わせるMixture-of-Experts(MoE)モデルのような、超巨大AIの推論を高速化するために作られています。 [3] その性能は、最大構成(9,216チップ)で42.5エクサフロップスという、世界トップクラスのスーパーコンピュータを24倍以上も上回る、まさに異次元の計算力を誇ります。 [6, 8]

- 驚異的な省エネ性能:AIの運用で問題になるのが消費電力と、それに伴う電気代や発熱です。Ironwoodは最新の液体冷却システムを採用し、前世代のTPUと比較して電力あたりの性能(ワットパフォーマンス)が約2倍に向上しています。 [4, 8] これは、同じ電力で2倍の仕事ができることを意味し、運用コストの削減と環境負荷の低減(グリーンAI)に大きく貢献します。初代のCloud TPUと比較すると、電力効率は約30倍にも向上しています。 [8]

- 巨大なメモリと高速通信:AIモデルが巨大になると、その分多くの情報を一時的に記憶しておく「メモリ」が必要になります。Ironwoodは1チップあたり192GBという大容量のメモリを搭載しており、これは前世代の6倍にもなります。 [1] さらに、チップ同士を繋ぐ通信速度(インターコネクト)も1.5倍に高速化されており、多数のチップが連携して動く際の遅延を最小限に抑えます。 [3, 6] これにより、巨大なモデルでもスムーズにデータをやり取りし、高速な応答が可能になります。

Ironwoodの驚異的なスペックを覗いてみよう

Ironwoodがどれほど強力なチップなのか、具体的なスペックをもう少し詳しく見てみましょう。専門用語も出てきますが、その凄さが伝わるはずです。

Google Cloudでは、Ironwoodを2種類の規模で提供するとしています。 [3, 9]

- 256チップ構成:比較的小規模な構成ですが、これだけでも現在のスーパーコンピュータに匹敵する計算能力を持ちます。中規模サービスの推論や、新しいAIモデルの実験などに適しています。

- 9,216チップ構成(フルPod):これが最大構成で、前述の通り42.5エクサフロップスという驚異的な性能を発揮します。 [1, 4] これは、1秒間に4京2500兆回もの計算ができる能力です。超巨大モデルの訓練や、国家レベルの研究プロジェクト、複数のAIサービスを同時に提供するような大規模基盤を支えることができます。 [9, 13]

この性能を支える主な技術仕様は以下の通りです。

| 項目 | スペック | 解説(何がすごいのか) |

|---|---|---|

| アーキテクチャ | 第7世代 TPU (Ironwood / TPU v7) | Googleが10年以上培ってきたノウハウを結集した、推論特化の最新設計。 [3, 12] |

| ピーク性能 | 4,614 TFLOPS (FP8精度) / チップ | 1チップで1秒間に4614兆回の計算が可能。推論でよく使われるFP8という計算形式をネイティブにサポートし、効率を最大化。 [2, 3] |

| メモリ | 192GB (HBM3) / チップ | 前世代の6倍の大容量メモリを搭載。巨大なAIモデルの情報を丸ごとチップ上に保持でき、データアクセスの待ち時間を削減。 [1, 6] |

| メモリ帯域幅 | 7.2 TB/s / チップ | 前世代の4.5倍のデータ転送速度。メモリとのデータのやり取りが非常に高速。 [1, 2] |

| チップ間通信 | 1.2 Tbps / チップ | チップ同士が連携する際の通信路が非常に太く、遅延が少ない。大規模な分散処理で性能を発揮。 [3, 4] |

| 冷却方式 | 液体冷却 | 高い性能を維持するために、従来の空冷より効率的な液体冷却システムを採用。 [4] |

なぜIronwoodはコストを半分にできるのか?TCO削減の秘密

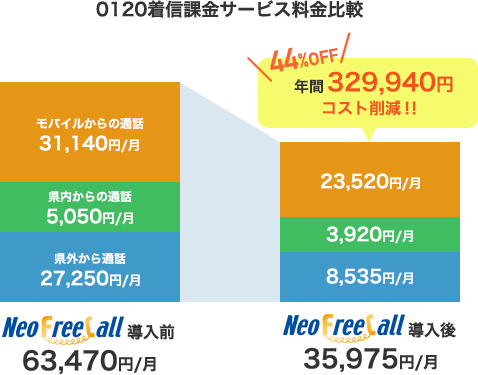

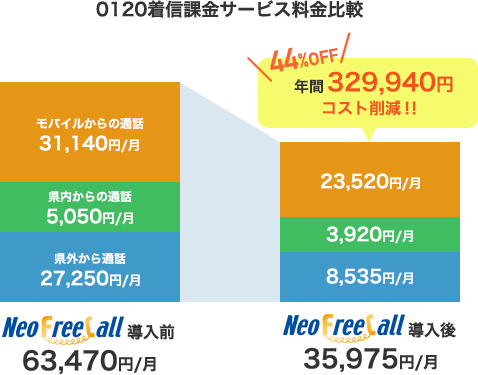

ビジネスにおいて最も気になるのは、やはり「コスト」でしょう。Ironwoodは、AI運用にかかるTCO(総所有コスト)を大幅に削減できると期待されています。TCOとは、単なる機材の購入費だけでなく、運用にかかる電気代や人件費など、トータルでかかる費用のことです。

Googleの試算によれば、特定のAIワークロードにおいて、従来のGPUを使った場合に比べて40%以上のコスト削減が可能になるとしています。さらに、前述の通り電力効率が2倍になっているため、電気代などの運用コストも大きく下がります。 [8]

これを簡単な比較表で見てみましょう。

| 項目 | 従来のGPUクラスタの場合 | Ironwood TPUの場合 |

|---|---|---|

| 年間の推論処理コスト(仮) | 1億円 | 約5,000万〜6,000万円(40-50%削減) |

| 消費電力・冷却コスト | 基準 (100%) | 約50% |

| 同じ予算で得られる性能 | 基準 (100%) | 約2倍 |

※上記はあくまで仮定に基づく概算です。

このように、Ironwoodを導入することで、AIサービスの運用コストを劇的に圧縮できる可能性があります。これは、同じ予算でより高性能なAIサービスを提供したり、これまでコスト面で見送っていた新しいAI活用に挑戦したりできることを意味します。 [10, 11] 最近では、これまでNVIDIA製GPUを主に使用してきたOpenAIでさえ、推論コスト削減のためにGoogleのTPUをテストしていると報じられており、業界全体の関心の高さがうかがえます。 [18]

【少し技術的な話】Ironwoodはどうやって使うの?

これほど強力なIronwoodですが、Google Cloudのサービスとして提供されるため、専門家でなくても比較的簡単に利用を開始できます。 [1]

特に、Terraformのような「Infrastructure as Code (IaC)」ツールを使うと、インフラの構成をコードで管理できるため、非常に便利です。 [16, 22] 手作業で一つ一つ設定するのではなく、設定ファイルに「こういう構成のTPUを使います」と記述するだけで、自動的に環境を構築・変更・削除できます。 [23] これにより、ヒューマンエラーを防ぎ、誰がやっても同じ環境を再現できるようになります。 [24]

以下は、TerraformでIronwoodのTPU環境を構築する際のコードのイメージです(Ironwoodが一般提供された後を想定)。

resource "google_tpu_node" "ironwood_demo" {

# TPUノード(サーバー)の名前

name = "ironwood-demo-node"

# 利用するTPUの種類(v7はIronwoodを指す)

accelerator_type = "v7-256"

# TensorFlowのバージョン

tensorflow_version = "2.15.0"

# 設置するデータセンターの場所

zone = "us-central2-b"

}

この例では、「v7-256」というタイプ(Ironwoodを256チップ搭載した構成)のTPUノードを定義しています。 [17] このようにコードでインフラを管理することで、運用の自動化や効率化が図れます。

Ironwoodを使いこなすための「監視」の重要性

高性能なスポーツカーも、メーターを見ずに運転していては性能を最大限に引き出せません。Ironwoodのような強力なインフラも同様で、その稼働状況をきちんと「監視(モニタリング)」することが、コスト効率とパフォーマンスを最大化する鍵となります。

Google CloudにはCloud Monitoringというサービスがあり、TPUの稼働状況を詳細に可視化できます。 [26] GoogleはTerraformで自動構築できるTPU専用の監視ダッシュボードテンプレートも提供しており、以下のような重要な指標を簡単に確認できます。 [5, 20]

- TensorCoreアイドル時間:TPUの頭脳である「TensorCore」がどれだけサボっているか(遊んでいるか)を示す時間です。この値が高いチップがある場合、仕事の割り振りが偏っている可能性があり、改善の余地があることを示します。 [5]

- メモリ使用量:TPUのメモリがどれくらい使われているかです。メモリが常に満杯に近い状態だと、性能のボトルネックになっている可能性があります。 [5]

- ネットワーク送受信量:チップ間の通信量を表します。ここが過剰に多い場合は、データのやり取りに無駄があるかもしれません。 [5]

こうしたダッシュボードを活用し、「TPUがサボらずしっかり働いているか?」「どこかに無理な負荷がかかっていないか?」を常にチェックすることが重要です。 [25, 27] また、「アイドル時間が一定以上続いたらアラートを出す」といった設定も可能で、リソースの無駄遣いを早期に発見できます。 [26]

まとめ:Ironwoodが切り拓くAIの未来

本記事では、Google Cloudが発表した最新の推論特化型TPU「Ironwood」について、その概要から性能、コスト削減効果、そして運用方法までを初心者向けに解説しました。 [3, 9, 14]

Ironwoodは、AIの「推論の時代」におけるコストと性能の課題を解決するために生まれた、まさにゲームチェンジャーとなりうる存在です。その主なポイントをもう一度おさらいしましょう。

- 推論特化設計:AIが実際に稼働する「推論」フェーズのコストと速度を劇的に改善。

- 圧倒的な性能と効率:世界最大級の計算能力と、前世代比2倍の電力効率を両立。 [4, 8]

- コスト削減効果:GPU利用時と比較して、TCO(総所有コスト)を大幅に削減できる可能性がある。

- クラウドでの容易な利用:Terraformなどを使えば、専門家でなくても強力なAIインフラをコードで管理・構築できる。 [16, 23]

Ironwoodのような専用ハードウェアの登場は、これまでコストの壁によって一部の巨大企業に限られていた高度なAI活用を、より多くの企業にとって身近なものにしていくでしょう。 [12] AIを自社サービスに組み込みたい、運用コストを下げて競争力を高めたいと考えているビジネスパーソンにとって、Ironwoodの動向は今後ますます見逃せないものとなります。

この記事が、最新のAIインフラ技術を理解し、ビジネス活用の可能性を探る一助となれば幸いです。

“`

最終出力(citationタグ除去後)

“`html

【初心者向け】Googleの推論特化AIチップ「Ironwood」とは?GPUとの違いやコスト削減効果を徹底解説

近年、ChatGPTをはじめとする生成AIの進化が目覚ましく、私たちのビジネスや生活に大きな変化をもたらしています。しかし、その裏側ではAIを動かすための膨大な計算が必要であり、特にAIが学習した知識を使って実際にタスクをこなす「推論(インファレンス)」のコストが増大し続けています。この課題を解決すべく、Googleは2025年4月に開催されたイベント「Google Cloud Next ’25」で、最新のAI専用チップ「Ironwood」を発表しました。

この記事では、AIの専門家ではないビジネスパーソンの方にも分かりやすく、以下の点を解説していきます。

- そもそもTPUとは何か、GPUと何が違うのか

- 最新TPU「Ironwood」の驚くべき性能と特徴

- なぜIronwoodはAIの運用コストを劇的に削減できるのか

- クラウド上での具体的な使い方や監視のポイント

AI導入のコスト課題に直面している方や、最新のAIインフラ技術の動向を把握したい方は、ぜひ最後までご覧ください。

AIの「訓練」と「推論」:なぜ今「推論」が重要なのか?

まず、AIの基本的な動作の2つのフェーズ、「訓練(トレーニング)」と「推論(インファレンス)」について簡単に理解しておきましょう。

- 訓練(トレーニング):AIモデルに大量のデータを与えて、賢くさせる「教育」の段階です。例えるなら、膨大な量の教科書や問題集を解かせて、知識を詰め込むイメージです。この段階では、一度に非常に大きな計算パワーが必要になります。

- 推論(インファレンス):訓練が終わったAIモデルが、未知のデータに対して予測や判断を行う「実践」の段階です。私たちがChatGPTに質問を投げかけ、答えが返ってくるのがまさにこの推論です。サービスが続く限り、継続的に計算処理が発生し続けます。

これまではAIモデルを賢くする「訓練」に注目が集まりがちでしたが、AIサービスが普及するにつれて、日々ユーザーのために動き続ける「推論」の計算量が爆発的に増加しています。一説には、大手AI企業の計算リソース予算の半分以上が推論に使われているとも言われています。 この「推論コストの増大」こそが、AIをビジネスで活用する上での大きな課題となっており、現在はAIの「推論の時代」とも呼ばれています。 Googleが発表したIronwoodは、まさにこの推論処理を、より速く、より安く、より効率的に行うために開発された切り札なのです。

Ironwoodとは?初心者にもわかる基本のキ

それでは、本題の「Ironwood」について見ていきましょう。Ironwoodを理解するために、まずはその土台となる「TPU」について解説します。

TPUとは? GPUとの違い

AIの計算には、これまで主に「GPU(Graphics Processing Unit)」が使われてきました。GPUは元々、パソコンやゲーム機で美しい映像を描画するための半導体チップですが、その高い並列計算能力がAIの計算にも適していたため、広く活用されてきました。

一方、TPU(Tensor Processing Unit)は、GoogleがAIの計算(特にニューラルネットワークで多用される行列演算)を高速化するためだけに開発した、まさに「AI専用チップ」です。 用途をAIに特化させているため、汎用的なGPUに比べて、AIの計算をより少ない電力で効率的に実行できるという強みがあります。 Google社内では、検索や翻訳、写真解析といったサービスの高速化のために10年以上も前から利用されてきました。

このTPUの最新世代(第7世代)が「Ironwood」であり、歴代で初めて「推論」に特化して設計されたモデルなのです。

Ironwoodのすごいところ3つのポイント

Ironwoodは「Google史上最も高性能かつエネルギー効率に優れたTPU」とされており、その特徴は多岐にわたりますが、ビジネスパーソンが押さえておくべきポイントは以下の3つです。

- 推論に最適化された世界最大級の性能:Ironwoodは、特に大規模言語モデル(LLM)や、複数の専門家AIを組み合わせるMixture-of-Experts(MoE)モデルのような、超巨大AIの推論を高速化するために作られています。 その性能は、最大構成(9,216チップ)で42.5エクサフロップスという、世界トップクラスのスーパーコンピュータを24倍以上も上回る、まさに異次元の計算力を誇ります。

- 驚異的な省エネ性能:AIの運用で問題になるのが消費電力と、それに伴う電気代や発熱です。Ironwoodは最新の液体冷却システムを採用し、前世代のTPUと比較して電力あたりの性能(ワットパフォーマンス)が約2倍に向上しています。 これは、同じ電力で2倍の仕事ができることを意味し、運用コストの削減と環境負荷の低減(グリーンAI)に大きく貢献します。初代のCloud TPUと比較すると、電力効率は約30倍にも向上しています。

- 巨大なメモリと高速通信:AIモデルが巨大になると、その分多くの情報を一時的に記憶しておく「メモリ」が必要になります。Ironwoodは1チップあたり192GBという大容量のメモリを搭載しており、これは前世代の6倍にもなります。 さらに、チップ同士を繋ぐ通信速度(インターコネクト)も1.5倍に高速化されており、多数のチップが連携して動く際の遅延を最小限に抑えます。 これにより、巨大なモデルでもスムーズにデータをやり取りし、高速な応答が可能になります。

Ironwoodの驚異的なスペックを覗いてみよう

Ironwoodがどれほど強力なチップなのか、具体的なスペックをもう少し詳しく見てみましょう。専門用語も出てきますが、その凄さが伝わるはずです。

Google Cloudでは、Ironwoodを2種類の規模で提供するとしています。

- 256チップ構成:比較的小規模な構成ですが、これだけでも現在のスーパーコンピュータに匹敵する計算能力を持ちます。中規模サービスの推論や、新しいAIモデルの実験などに適しています。

- 9,216チップ構成(フルPod):これが最大構成で、前述の通り42.5エクサフロップスという驚異的な性能を発揮します。 これは、1秒間に4京2500兆回もの計算ができる能力です。超巨大モデルの訓練や、国家レベルの研究プロジェクト、複数のAIサービスを同時に提供するような大規模基盤を支えることができます。

この性能を支える主な技術仕様は以下の通りです。

| 項目 | スペック | 解説(何がすごいのか) |

|---|---|---|

| アーキテクチャ | 第7世代 TPU (Ironwood / TPU v7) | Googleが10年以上培ってきたノウハウを結集した、推論特化の最新設計。 |

| ピーク性能 | 4,614 TFLOPS (FP8精度) / チップ | 1チップで1秒間に4614兆回の計算が可能。推論でよく使われるFP8という計算形式をネイティブにサポートし、効率を最大化。 |

| メモリ | 192GB (HBM3) / チップ | 前世代の6倍の大容量メモリを搭載。巨大なAIモデルの情報を丸ごとチップ上に保持でき、データアクセスの待ち時間を削減。 |

| メモリ帯域幅 | 7.2 TB/s / チップ | 前世代の4.5倍のデータ転送速度。メモリとのデータのやり取りが非常に高速。 |

| チップ間通信 | 1.2 Tbps / チップ | チップ同士が連携する際の通信路が非常に太く、遅延が少ない。大規模な分散処理で性能を発揮。 |

| 冷却方式 | 液体冷却 | 高い性能を維持するために、従来の空冷より効率的な液体冷却システムを採用。 |

なぜIronwoodはコストを半分にできるのか?TCO削減の秘密

ビジネスにおいて最も気になるのは、やはり「コスト」でしょう。Ironwoodは、AI運用にかかるTCO(総所有コスト)を大幅に削減できると期待されています。TCOとは、単なる機材の購入費だけでなく、運用にかかる電気代や人件費など、トータルでかかる費用のことです。

Googleの試算によれば、特定のAIワークロードにおいて、従来のGPUを使った場合に比べて40%以上のコスト削減が可能になるとしています。さらに、前述の通り電力効率が2倍になっているため、電気代などの運用コストも大きく下がります。

これを簡単な比較表で見てみましょう。

| 項目 | 従来のGPUクラスタの場合 | Ironwood TPUの場合 |

|---|---|---|

| 年間の推論処理コスト(仮) | 1億円 | 約5,000万〜6,000万円(40-50%削減) |

| 消費電力・冷却コスト | 基準 (100%) | 約50% |

| 同じ予算で得られる性能 | 基準 (100%) | 約2倍 |

※上記はあくまで仮定に基づく概算です。

このように、Ironwoodを導入することで、AIサービスの運用コストを劇的に圧縮できる可能性があります。これは、同じ予算でより高性能なAIサービスを提供したり、これまでコスト面で見送っていた新しいAI活用に挑戦したりできることを意味します。 最近では、これまでNVIDIA製GPUを主に使用してきたOpenAIでさえ、推論コスト削減のためにGoogleのTPUをテストしていると報じられており、業界全体の関心の高さがうかがえます。

【少し技術的な話】Ironwoodはどうやって使うの?

これほど強力なIronwoodですが、Google Cloudのサービスとして提供されるため、専門家でなくても比較的簡単に利用を開始できます。

特に、Terraformのような「Infrastructure as Code (IaC)」ツールを使うと、インフラの構成をコードで管理できるため、非常に便利です。 手作業で一つ一つ設定するのではなく、設定ファイルに「こういう構成のTPUを使います」と記述するだけで、自動的に環境を構築・変更・削除できます。 これにより、ヒューマンエラーを防ぎ、誰がやっても同じ環境を再現できるようになります。

以下は、TerraformでIronwoodのTPU環境を構築する際のコードのイメージです(Ironwoodが一般提供された後を想定)。

resource "google_tpu_node" "ironwood_demo" {

# TPUノード(サーバー)の名前

name = "ironwood-demo-node"

# 利用するTPUの種類(v7はIronwoodを指す)

accelerator_type = "v7-256"

# TensorFlowのバージョン

tensorflow_version = "2.15.0"

# 設置するデータセンターの場所

zone = "us-central2-b"

}

この例では、「v7-256」というタイプ(Ironwoodを256チップ搭載した構成)のTPUノードを定義しています。 このようにコードでインフラを管理することで、運用の自動化や効率化が図れます。

Ironwoodを使いこなすための「監視」の重要性

高性能なスポーツカーも、メーターを見ずに運転していては性能を最大限に引き出せません。Ironwoodのような強力なインフラも同様で、その稼働状況をきちんと「監視(モニタリング)」することが、コスト効率とパフォーマンスを最大化する鍵となります。

Google CloudにはCloud Monitoringというサービスがあり、TPUの稼働状況を詳細に可視化できます。 GoogleはTerraformで自動構築できるTPU専用の監視ダッシュボードテンプレートも提供しており、以下のような重要な指標を簡単に確認できます。

- TensorCoreアイドル時間:TPUの頭脳である「TensorCore」がどれだけサボっているか(遊んでいるか)を示す時間です。この値が高いチップがある場合、仕事の割り振りが偏っている可能性があり、改善の余地があることを示します。

- メモリ使用量:TPUのメモリがどれくらい使われているかです。メモリが常に満杯に近い状態だと、性能のボトルネックになっている可能性があります。

- ネットワーク送受信量:チップ間の通信量を表します。ここが過剰に多い場合は、データのやり取りに無駄があるかもしれません。

こうしたダッシュボードを活用し、「TPUがサボらずしっかり働いているか?」「どこかに無理な負荷がかかっていないか?」を常にチェックすることが重要です。 また、「アイドル時間が一定以上続いたらアラートを出す」といった設定も可能で、リソースの無駄遣いを早期に発見できます。

まとめ:Ironwoodが切り拓くAIの未来

本記事では、Google Cloudが発表した最新の推論特化型TPU「Ironwood」について、その概要から性能、コスト削減効果、そして運用方法までを初心者向けに解説しました。

Ironwoodは、AIの「推論の時代」におけるコストと性能の課題を解決するために生まれた、まさにゲームチェンジャーとなりうる存在です。その主なポイントをもう一度おさらいしましょう。

- 推論特化設計:AIが実際に稼働する「推論」フェーズのコストと速度を劇的に改善。

- 圧倒的な性能と効率:世界最大級の計算能力と、前世代比2倍の電力効率を両立。

- コスト削減効果:GPU利用時と比較して、TCO(総所有コスト)を大幅に削減できる可能性がある。

- クラウドでの容易な利用:Terraformなどを使えば、専門家でなくても強力なAIインフラをコードで管理・構築できる。

Ironwoodのような専用ハードウェアの登場は、これまでコストの壁によって一部の巨大企業に限られていた高度なAI活用を、より多くの企業にとって身近なものにしていくでしょう。 AIを自社サービスに組み込みたい、運用コストを下げて競争力を高めたいと考えているビジネスパーソンにとって、Ironwoodの動向は今後ますます見逃せないものとなります。

この記事が、最新のAIインフラ技術を理解し、ビジネス活用の可能性を探る一助となれば幸いです。