初心者のための生成AIガバナンス委員会立ち上げ完全ガイド【リスク管理から監査対応まで】

近年、ChatGPTに代表される生成AI(ジェネレーティブAI)の進化は目覚ましく、企業の業務効率化や新しいサービス開発に大きな可能性をもたらしています。しかしその一方で、「会社の機密情報を入力して漏洩しないか」「AIが作った文章が誰かの著作権を侵害していたらどうしよう」「AIの間違った回答を信じて業務で失敗したら?」といったリスクを懸念する声も少なくありません。事実、多くの企業が当初は生成AIの利用を禁止・制限していました。 [note.com] しかし、競合他社がAI活用で成果を上げる中、単に「禁止」するだけでは競争から取り残されてしまいます。そこで重要になるのが、リスクを適切に管理し、AIの恩恵を安全に享受するための社内体制、すなわち「AIガバナンス」の構築です。 [note.com] この記事では、AIの専門家ではないビジネスパーソンの方にも分かりやすく、社内に「生成AIガバナンス委員会」を立ち上げ、機能させるための具体的な方法を、目的設定から監査対応までステップバイステップで徹底解説します。

1. AIガバナンス委員会とは?その目的と役割

まず、「生成AIガバナンス委員会」とは何か、なぜ必要なのかを理解しましょう。

ガバナンス委員会の目的は「安心してAIを使うため」

生成AIガバナンス委員会とは、社内でAIを安全かつ効果的に活用するために、様々な部門の担当者を集めて作る横断的なチームのことです。 [legalon-cloud.com, legalon-cloud.com] その目的は、AI利用に伴うリスクを管理し、法律や倫理を守りながらAIを使いこなすための社内ルールや体制を整備・監督することにあります。 [legalon-cloud.com] これは「AI利用を禁止するための組織」ではなく、むしろ「AIを安心してビジネスに活かすための土台を作る推進組織」と捉えることが成功の鍵です。 [legalon-cloud.com]

なぜ専門の委員会が必要なのか?

生成AIには、これまでのITツールにはなかった特有のリスクが存在します。 [kpmg.com] これらが現実になれば、企業に深刻なダメージを与えかねません。 [kpmg.com]

- 機密情報の漏洩:社員が顧客情報や開発中の製品情報などをAIに入力してしまい、外部に流出するリスク。 [kpmg.com]

- 知的財産権の侵害:AIが生成した文章や画像が、他社の著作物や商標と偶然似てしまい、権利を侵害してしまうリスク。 [kpmg.com]

- 誤情報(ハルシネーション):AIが事実に基づかない、もっともらしい嘘の情報を生成し、それを信じた結果、ビジネス上の判断を誤るリスク。 [note.com, kpmg.com]

- 不適切なコンテンツ:AIが差別的、暴力的、非倫理的な内容を出力し、企業の評判を大きく損なうリスク。 [kpmg.com]

- セキュリティの脅威:AIが悪用され、ウイルス作成やサイバー攻撃の新たな手口を生み出すリスク。 [ipa.go.jp, ipa.go.jp]

これらの新しいリスクに適切に対処するためには、法務、IT、事業部門、人事といった各分野の専門知識を結集する必要があるのです。 [note.com, cio.com]

委員会の具体的な役割

ガバナンス委員会は、経営層のサポートのもと、以下のような多岐にわたる役割を担います。

- 全社方針(ポリシー)の策定:企業の理念に基づき、「人間中心」「プライバシー保護」といったAI活用の大原則を定めます。 [cio.com]

- 利用ガイドラインの整備:方針に基づき、「この業務ではAI利用OK」「個人情報の入力は禁止」といった現場で使える具体的なルールを作成します。 [note.com]

- リスクの評価と監督:新しいAIツールの導入前に、安全性や法的な問題をチェックする仕組みを構築し、定期的にリスクを見直します。 [newton-consulting.co.jp, note.com]

- 社員教育の計画と実施:全社員に向けて、AIの正しい使い方やリスクに関する研修を行い、リテラシー向上を図ります。 [note.com, note.com]

- 利用状況の監視と改善:AIの利用状況をモニタリングし、問題が発生した際の報告体制を整え、ルールを継続的に改善していきます。 [note.com, legalon-cloud.com]

2. 社内ルールの整備方法:ガイドラインと研修

ガバナンス委員会が最初に取り組むべき重要なタスクが、社内ルールの策定です。ルール作りは、安全なAI活用の第一歩と言えます。

「ポリシー」と「ガイドライン」の二階建てで考える

ルールを整備する際は、抽象的な「基本規定(ポリシー)」と、具体的な「利用ガイドライン」の二階建てで考えると分かりやすいでしょう。 [cio.com]

- 基本規定(ポリシー):企業のAI利用に関する最上位の方針。「人権を尊重する」「最終的な判断は人間が行う」といった、全社共通の理念を定めます。 [cio.com]

- 利用ガイドライン:ポリシーを具体的な行動に落とし込んだ手引書。「資料の要約や翻訳には使って良いが、契約書の作成は不可」といった、業務レベルでのルールを明記します。 [cio.com, note.com]

ガイドラインに盛り込むべき主要項目

現場の社員が迷わず使えるガイドラインを作成するために、以下の項目を盛り込むのが一般的です。 [note.com]

- 利用目的と範囲:どの業務でAIを使ってよいか、逆に禁止する業務は何かを明確にします。 [note.com]

- 許可するAIツール:会社がセキュリティを確認し、利用を許可したAIサービス(例:ChatGPT Enterprise版など)をリスト化します。 [note.com]

- 入力データのルール:「顧客の個人情報」「社外秘の経営情報」など、入力してはいけない情報の種類を具体的に定めます。 [note.com, kpmg.com]

- 生成物の取り扱い:AIが作った文章や画像を、そのまま顧客に提出せず、必ず人間が内容をチェック(ファクトチェック)する、といったルールを設けます。 [note.com]

- ログの取得と監査:AIの利用履歴は記録・監査されることを明記し、不正利用を抑止します。 [note.com]

- 教育と研修:ガイドラインを学ぶ研修の受講を義務化するなど、ルールの定着を図る仕組みを定めます。 [note.com]

- 責任体制と報告フロー:困ったときや問題が起きたときの相談窓口や報告手順を明確にします。 [note.com]

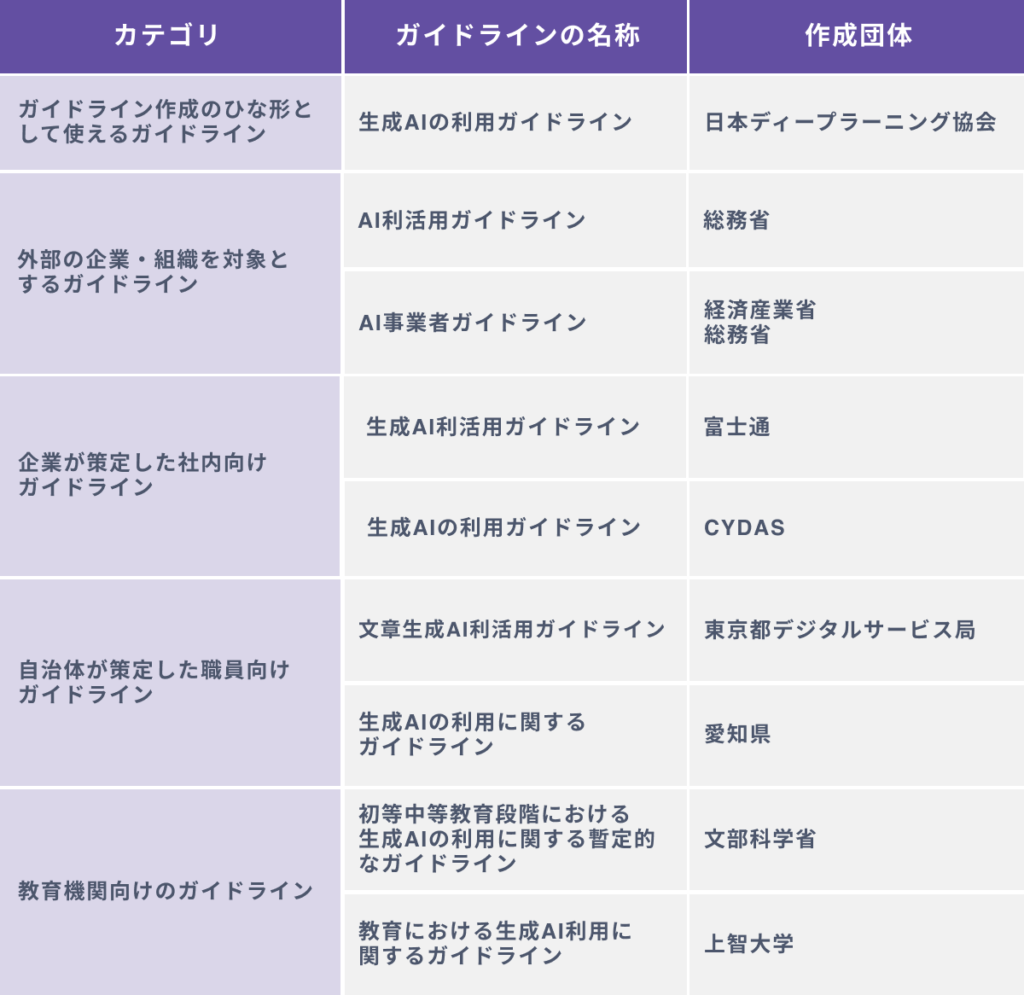

一から作成するのは大変ですが、日本ディープラーニング協会(JDLA)が公開している「生成AIの利用ガイドライン」の雛形などを参考にすると、効率的に自社に合ったルールを作成できます。 [note.com, jdla.org, jdla.org]

ルールの周知とアップデート

ルールは作って終わりではありません。全社員への研修を通じて内容を周知徹底し、AI技術や社会状況の変化に合わせて、ガバナンス委員会が定期的に見直し、更新していくことが不可欠です。 [cio.com, note.com]

3. 監査ログの運用:利用状況を「見える化」する

AIガバナンスを絵に描いた餅にしないためには、「誰が、いつ、AIで何をしたか」を後から検証できる仕組み、すなわち監査ログの管理が極めて重要です。

なぜログ管理が重要なのか?

万が一、情報漏洩や不適切な利用といった問題が発生した際に、その原因を特定し、迅速に対処するためにログは不可欠です。 [ipa.go.jp] 例えば、「顧客に誤った情報を回答してしまった」というトラブルが起きた場合、その時にAIに何を入力し、AIがどう回答したかの記録が残っていれば、原因究明と再発防止策の検討が容易になります。

何を記録すべきか?

最低限、以下の情報はセットで記録・保管することが推奨されます。 [ipa.go.jp]

- 入力プロンプト:ユーザーがAIに入力した質問や指示

- AIからの出力:AIが生成した回答やコンテンツ

- 利用者ID:操作を行った社員の識別情報

- 実行日時:操作が行われた正確な時刻

- 使用したAIサービス名:どのAIモデルを利用したかの情報

これらのログは、社員が直接外部のAIサービスを使う形では管理が難しいため、多くの企業ではAPIを経由する社内専用のAI利用ポータルを構築し、そこで全ユーザーのやり取りを一元的に記録する仕組みを導入しています。 [note.com]

ログの監視と技術的な対策

記録したログは、定期的に分析する必要があります。 [note.com] 例えば、「機密」といった禁止キーワードが含まれていないかシステムで自動スキャンしたり、無作為にログを抽出して人の目でチェックしたりする方法があります。 [note.com] さらに、問題のある入力を未然に防ぐ「技術的ガードレール」も有効です。 [note.com, ipa.go.jp] 例えば、マイナンバーのような特定の文字列が入力された瞬間にブロックするといったフィルター機能を実装することで、リスクを大幅に低減できます。 [ipa.go.jp]

4. 週次レビューで確認すべき項目:PDCAを回し続ける

生成AIを取り巻く環境は、驚くべきスピードで変化します。そのため、ガバナンス委員会が定期的に集まり、状況を確認・評価する「レビュー会議」が欠かせません。週に一度程度の頻度で実施するのが理想的です。 [cio.com]

週次レビューで主に確認すべき項目は以下の通りです。

- AIモデルやサービスの変更点:利用中のAIサービスにアップデートや規約変更がなかったかを確認し、社内ルールへの影響を評価します。

- リスクやヒヤリハットの共有:ログ監査で見つかった気になる点や、現場から報告された「ヒヤリとした、ハッとした」事例を共有し、対策を検討します。 [note.com]

- インシデントの対応状況:実際に発生したトラブルの報告内容と、その原因分析、再発防止策の進捗を確認します。 [note.com]

- AI利用状況の数値分析:社内の利用ユーザー数や、各部署での活用頻度などを数値で把握し、活用推進や課題発見に繋げます。

- 国内外の規制動向の確認:EUのAI法など、国内外の法規制やガイドラインの最新情報を収集し、自社への影響を議論します。 [legalon-cloud.com, legalon-cloud.com, legalon-cloud.com]

- 社内からの提案や質問への対応:現場から寄せられた「この業務にもAIを使いたい」といった要望や質問に対応方針を決め、ルールや体制の改善に活かします。 [note.com]

このように、計画(Plan)、実行(Do)、評価(Check)、改善(Action)のPDCAサイクルを高速で回し続けることが、実効性のあるAIガバナンス体制を維持する秘訣です。 [legalon-cloud.com]

5. リスク登録票の作成と活用:リスクを「管理可能」にする

AI利用に伴う様々なリスクを整理し、管理するための強力なツールが「リスク登録票(リスクレジスター)」です。これは、想定されるリスクを一覧表にして、優先順位付けや対策の進捗管理を行うための文書です。

リスク登録票の基本フォーマット

初心者でも扱いやすいシンプルなリスク登録票には、以下のような項目が含まれます。 [asana.com]

- リスクの説明:どんなリスクか(例:機密情報の漏洩)

- リスクの詳細:どのような状況で発生し、何が起こるか

- カテゴリー:リスクの種類(例:セキュリティ、コンプライアンス)

- 発生可能性:そのリスクが起こる確率(高・中・低など) [asana.com]

- 影響度:発生した場合の被害の大きさ(高・中・低など) [asana.com]

- 優先度:「発生可能性 × 影響度」で算出される対応の優先順位

- 対策内容:リスクを減らすための具体的なアクション

- 責任者:その対策を進める担当部署や担当者 [asana.com]

- ステータス:対策の進捗状況(未着手、実施中、完了など) [asana.com]

リスク登録票の記入例

以下は、生成AIガバナンスに関するリスク登録票の簡単な記入例です。

| リスク説明 | カテゴリー | 発生可能性 | 影響度 | 優先度 | 対策(緩和策) | 責任者 | ステータス |

|---|---|---|---|---|---|---|---|

| 機密情報のAI入力による情報漏洩 | プライバシー | 高 | 高 | A | ガイドラインで入力禁止を規定。入力検知フィルターを実装し、監査ログを全件保存。 [ipa.go.jp] | 情報システム部 | 対策実施中 |

| AIの誤回答(ハルシネーション)による業務ミス | 業務オペレーション | 中 | 中 | B | 重要判断にAI回答を用いる際はダブルチェックを義務化。社員研修でAIの限界を教育。 [ipa.go.jp] | ガバナンス委員会 | 監視継続中 |

| 生成コンテンツの著作権侵害 | コンプライアンス | 低 | 中 | C | 生成物の外部利用時は権利チェック手順を導入。社員への注意喚起を強化。 | 法務部 | 計画策定中 |

この登録票をガバナンス委員会の定例会議などで常に見直し、更新していくことで、リスクへの対応漏れを防ぎ、組織全体のリスク管理能力を高めることができます。 [asana.com]

6. 社外監査への対応準備:説明責任を果たすために

AIの活用が進むと、取引先や規制当局、あるいは顧客から「あなたの会社はAIのリスクにどう対応していますか?」と問われる場面が出てきます。このような社外監査に備え、自社の取り組みをきちんと説明できる準備をしておくことが重要です。

監査で問われるのは完璧さよりも、継続的に改善しようとしている姿勢です。以下の点を準備しておくことで、いざという時に慌てず、自信をもって説明責任を果たすことができます。 [cio.com]

- 関連文書の一元管理:AI利用ポリシーやガイドライン、委員会の議事録、リスク登録票、研修の実施記録などを、いつでも取り出せるように整理・保管しておきます。

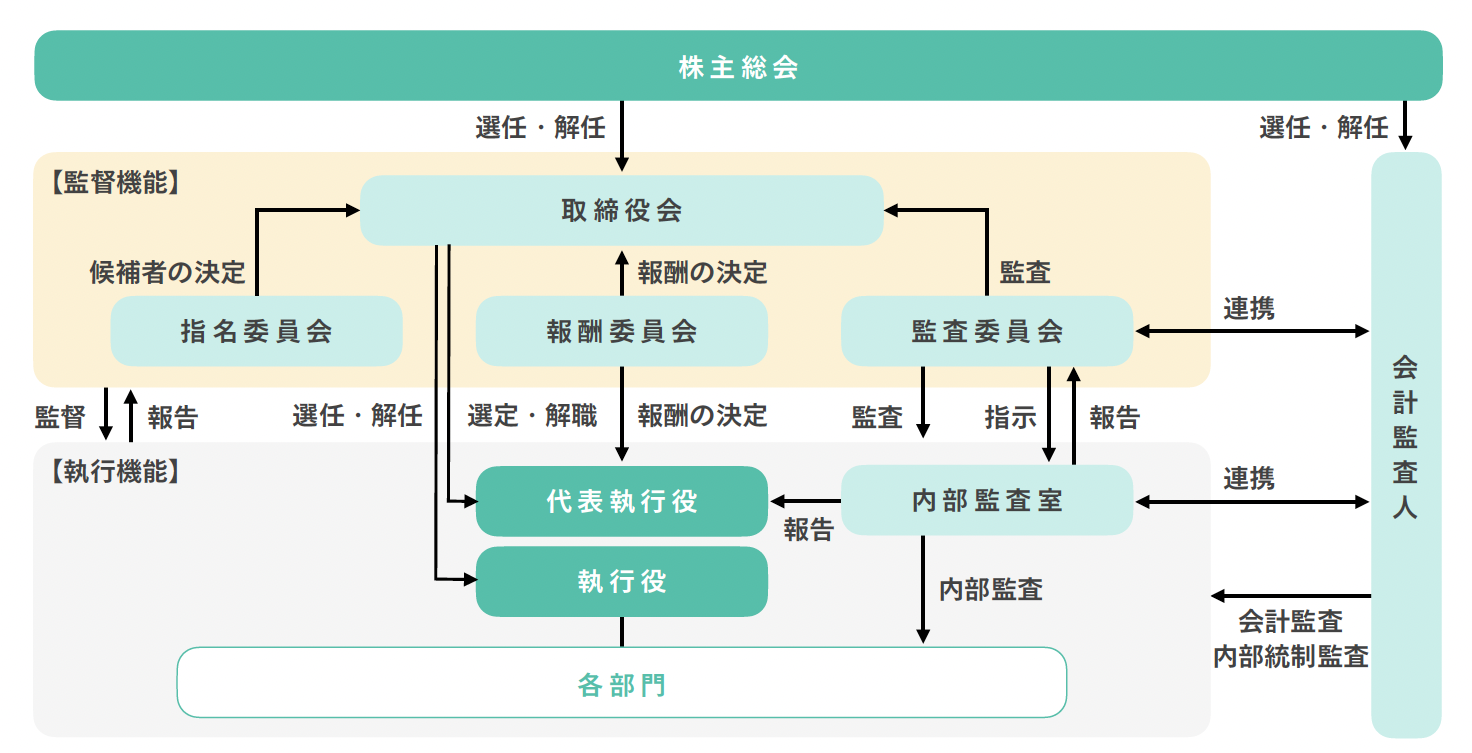

- 体制とプロセスの可視化:ガバナンス委員会の体制図や、問題発生時の報告フローなどを図にしておくと、誰にでも分かりやすく説明できます。

- 証跡(エビデンス)の整理:「実際にログを監査しています」と口で言うだけでなく、「直近3ヶ月の監査記録です」と具体的な証拠を示せるように準備しておきます。

- 外部基準との対比:自社の取り組みが、経済産業省のガイドラインや国際的なAI原則(OECD原則など)と、どのように対応しているかを整理した資料を用意しておくと説得力が増します。

- 説明リハーサルの実施:「ルール違反者にはどう対処しますか?」といった想定質問に対する回答を準備し、担当者間でリハーサルしておくと安心です。

現時点では日本にAIガバナンスを直接義務付ける法律はありませんが、今後、規制が強化される可能性は十分にあります。 [legalon-cloud.com] 先んじてガバナンス体制を整え、いつでも説明責任を果たせるようにしておくことは、企業の信頼性を高め、結果として競争力の強化にも繋がるのです。 [legalon-cloud.com, legalon-cloud.com]

本記事では、生成AIガバナンス委員会の立ち上げから運用、監査対応までの一連の流れを解説しました。最も重要なポイントは、「やみくもに禁止するのではなく、安全に使うためのガードレールを設けて、安心してAIを活用する」という考え方です。 [cio.com] 最初は手探りかもしれませんが、経営層のリーダーシップのもと、全社を巻き込みながらガバナンス体制を構築・改善していくことで、企業は生成AIという強力なツールがもたらすリスクを最小限に抑え、その恩恵を最大限に引き出すことができるでしょう。

参考文献・資料

- 経済産業省・総務省「AI事業者ガイドライン」 [meti.go.jp, legalon-cloud.com]

- 日本ディープラーニング協会(JDLA)「生成AIの利用ガイドライン」 [jdla.org, jdla.org]

- 情報処理推進機構(IPA)「テキスト生成AIの導入・運用ガイドライン」 [ipa.go.jp, ipa.go.jp]