【2025年最新版】AIコンテンツの品質を劇的に向上させる!初心者向けチェックリスト完全ガイド

AI(人工知能)を活用した文章作成が急速に普及し、ビジネスの現場で欠かせないツールとなりつつあります。しかし、その手軽さの裏側で、生成されるコンテンツの「品質」をいかに担保するかという新たな課題が浮上しています。特に、AIが事実に基づかない情報を生成する「ハルシネーション(幻覚)」は、企業の信頼性を揺るかしかねない深刻な問題です。 [7, 14, 17] この記事では、AI利用の初心者であるビジネスパーソンの皆さんでも今日から実践できる、AI生成コンテンツの品質を担保するための最新チェックリストを、2025年現在の情報に基づき、分かりやすく徹底解説します。

1. 出典や根拠の明示 – 情報の信頼性を盤石にする

✓ チェック項目: AIが生成した文章中のデータや主張には必ず出典(ソース)を明記し、読者が事実を検証できるようにする。引用のルール(著作権法上の要件)も守る。

AIが生成したコンテンツの信頼性を高める上で最も基本的なステップが、情報の出典や根拠を明確にすることです。AIは膨大なデータから文章を生成しますが、「どの情報源に基づいているか」を自ら示すことは稀です。そのため、私たち人間がその根拠を補い、読者に提示する必要があります。 [13] 特に、統計データ、専門的な事実、具体的な数値を記載する際は、出典の明記が不可欠です。 [19]

なぜ出典明示が重要なのか?

- 信頼性の向上: 公的機関の統計や権威ある研究機関のレポートなど、信頼性の高い情報源を提示することで、コンテンツ全体の説得力が増します。 [13, 19]

- 読者の安心感: 読者は情報がどこから来たのかを知ることで、安心して内容を読み進めることができます。また、自ら元情報を確認することも可能になります。

- 誤情報拡散の防止: 出典が明確であれば、万が一AIが誤った情報を生成しても、ファクトチェックの過程で発見・修正しやすくなります。 [13]

実践方法とポイント

具体的な実践方法はシンプルです。「総務省の調査によると、2025年時点の国内インターネット利用率は90%を超える」のように、事実を述べた直後に情報源を記載します。さらに、記事の末尾に参考文献リストとしてURLをまとめて掲載すると、より丁寧な印象を与えます。

また、他者の文章やデータをそのまま使用する場合は、著作権法で定められた「引用」のルールを遵守しなければなりません。 [22, 30] 引用部分をカギ括弧やブロッククオート(<blockquote>)で明確に区別し、出所を明記することが法律で義務付けられています。 [38]

【引用の基本ルール】 ・引用部分が明確に区別されていること ・出典元が明記されていること ・引用する必要性があること ・内容を改変しないこと

便利な支援ツール

最近では、出典管理を助けるツールも登場しています。例えば、Microsoftの「Copilot」は文章作成中に関連する情報源を提示する機能があり、参考文献リストの作成をサポートします。また、ChatGPTの拡張機能や、情報源を明記しながら回答を生成するAI(例: Perplexity AI)を活用するのも有効な手段です。 [21] ただし、AIが提示した出典情報が常に正しいとは限らないため、最終的には必ず人間の目でリンク先を確認する作業が必要です。 [21]

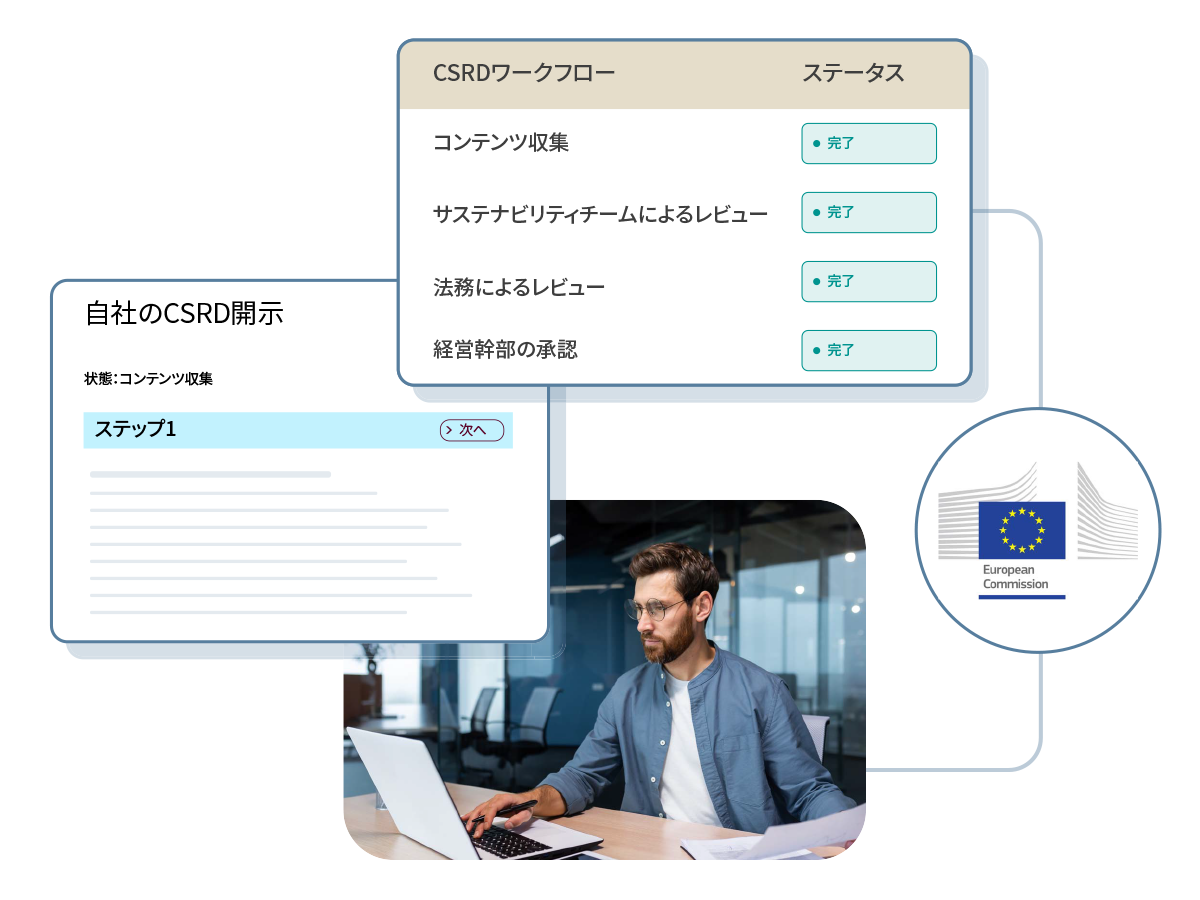

2. 検収者(レビュー担当者)の配置 – 人間の目で品質を保証する

✓ チェック項目: AIが作成したコンテンツをそのまま公開せず、必ず人間によるレビュー(検収)工程を設ける。可能であれば、複数人によるダブルチェック体制を構築する。

AIはあくまで強力な「下書きツール」であり、最終的な品質責任は人間が負うべきです。 [10, 23] AIは文法的な誤りや単純なミスを見つけるのは得意ですが、文脈に応じた細かなニュアンス、ブランドイメージに沿ったトーン&マナー、倫理的な配慮といった点は判断できません。 [10] そのため、AIが生成した文章を人間の検収者がレビューするプロセスは、品質管理の要となります。 [26]

なぜ人間のレビューが不可欠なのか?

- 文脈とニュアンスの判断: 読者の感情に寄り添った表現や、企業として発信するにふさわしい言葉遣いになっているかをチェックします。

- 事実確認(ファクトチェック): AIが生成した情報に誤りがないか、前述の出典確認と合わせて検証します。

- 独自性とE-E-A-Tの強化: Googleはコンテンツの品質を評価する基準として「E-E-A-T」(経験・専門性・権威性・信頼性)を重視しています。 [25, 29] AIが生成した一般的な情報に、人間が独自の経験や専門的な知見を加えることで、コンテンツの価値は飛躍的に高まります。 [32, 39]

- ブランドイメージの維持: 企業のブランドガイドラインに沿った、一貫性のあるメッセージングになっているかを確認します。 [15]

効果的なレビュー体制の構築例

理想的なのは、役割を分担した多段階のチェックフローです。 [26] これにより、チェックの抜け漏れを防ぎ、コンテンツの品質を多角的に高めることができます。

| フェーズ | 担当者 | 主なチェック項目 |

|---|---|---|

| Phase 1: 一次レビュー | コンテンツ作成者 | 誤字脱字、基本的な構成、AI特有の不自然な表現の修正 |

| Phase 2: 専門性・事実確認 | 分野の専門家 or 上長 | 専門用語の正確性、データの裏付け、情報の最新性、E-E-A-Tの観点からの追記・修正 |

| Phase 3: 最終校正 | 編集責任者 or 別部署の担当者 | ブランドトーンとの整合性、読者視点での分かりやすさ、SEO要件の最終確認 |

このような体制が難しい場合でも、「作成者以外の第三者が必ず一度は目を通す」というルールを設けるだけで、品質は大きく向上します。共同編集ツール(例: Googleドキュメント、Shodo)を活用し、修正履歴を残しながらレビューを進めるのも効率的です。 [6]

3. 誤情報(AIハルシネーション)の検出と修正ログの活用

✓ チェック項目: AIの出力内容に誤りや根拠のない部分がないか徹底的に検証し、発見した場合は修正すると共に、その内容を「修正ログ」として記録・共有する。

AIのハルシネーションは、AIが学習データに存在しない情報を、あたかも事実であるかのように生成する現象です。 [7, 17] 例えば、存在しない判例を引用したり、架空の歴史的事実を語ったりすることがあります。 [14] これらを防ぐには、「AIの回答は間違っている可能性がある」という前提に立ち、厳格な検出プロセスを導入することが不可欠です。 [12]

ハルシネーションの検出方法

- 徹底したファクトチェック: 固有名詞、日付、数値、法律名など、検証可能な情報はすべて信頼できる一次情報源(公式サイト、公的文書など)と照合します。 [13, 19]

- 複数AIでのクロスチェック: 同じ質問をChatGPT、Gemini、Claudeなど複数の異なるAIに投げかけ、回答を比較します。 [20] 全員が一致する回答は信頼性が高い一方、回答が分かれる部分は要注意です。

- 検索拡張生成(RAG)の活用: RAG (Retrieval-Augmented Generation) とは、AIが回答を生成する前に、指定されたデータベースやウェブから関連情報を検索し、その内容に基づいて回答を作成する技術です。 [1, 2, 3] これにより、AIが完全にゼロから情報を「創作」するのを防ぎ、ハルシネーションを大幅に抑制できます。 [4, 7]

- 疑わしい表現への注意: 「驚くべきことに」「最新の研究によると」といった、根拠が曖昧で大げさな表現は、ハルシネーションの兆候である可能性があります。

なぜ「修正ログ」が重要なのか?

誤りを発見して修正するだけでなく、その履歴を記録・管理(ログ管理)することが、長期的な品質向上に繋がります。 [41, 47] 修正ログとは、「いつ、誰が、どの部分を、なぜ、どのように修正したか」を記録したものです。 [43, 44]

- 再発防止: 「このAIモデルは統計データの誤りが多い」「このテーマでは架空の事例を作りやすい」といった、AIの弱点や癖をチームで共有し、今後のプロンプト設計やレビューに活かすことができます。

- 品質管理の可視化: 修正ログを分析することで、「AI生成物の修正率」といった指標を設け、運用プロセスの改善効果を測定できます。

- 教育・ナレッジ共有: 蓄積された修正事例は、新たなレビュー担当者への教育資料や、社内の「AI利用ガイドライン」の具体例として活用できます。

修正ログの管理には、共有のスプレッドシートやプロジェクト管理ツールが役立ちます。WordやGoogleドキュメントの「変更履歴の記録」機能も手軽で効果的です。

4. 全社的な運用ルールの標準化(コンテンツガバナンス)

✓ チェック項目: これまでのチェック項目を盛り込んだ、全社共通の「AIコンテンツ作成ガイドライン」を策定し、定期的に見直し・更新する体制を整える。

個人のスキルに依存するのではなく、組織全体でAIコンテンツの品質を安定させるためには、明確なルール(ガバナンス)の確立が不可欠です。 [42, 45]

ガイドラインに含めるべき項目

- AI利用の基本方針: 「AIは補助ツールであり、最終的な文責は人間が負う」といった基本原則を明記します。

- コンテンツ作成フロー: 「企画→AIで草稿作成→一次レビュー→ファクトチェック→最終承認→公開」といった標準的なプロセスと、各段階での責任者を定めます。 [26]

- 禁止事項: 機密情報や個人情報の入力を禁止するなど、セキュリティに関するルールを定めます。 [42]

- 使用ツール: 会社として推奨するAIツール、ファクトチェックツール、コピペチェックツールなどを指定します。

–品質チェックリスト: 本記事で紹介した「出典の明示」「ハルシネーションの確認」などの項目を具体的なチェックリストとして文書化します。 [31, 40]

このガイドラインは一度作って終わりではなく、AI技術の進化や社内での活用事例の蓄積に応じて、四半期に一度など定期的に見直し、アップデートしていくことが重要です。

まとめ

AIはコンテンツ作成の生産性を劇的に向上させる強力な武器ですが、その力を最大限に引き出し、同時にリスクを管理するためには、人間による丁寧な品質管理が不可欠です。AIと人間がそれぞれの強みを活かして協働することで、効率的かつ高品質なコンテンツ制作が可能になります。 [23]

今回ご紹介した4つのチェックポイント――①出典の明示、②人間によるレビュー、③誤情報の検出とログ活用、④運用ルールの標準化――を実践することで、AIの「暴走」を防ぎ、読者から真に信頼されるコンテンツを発信し続けることができます。ぜひ、本日の内容を参考に、自社のAI活用プロセスを見直し、より安全で効果的なコンテンツ制作体制を構築してください。

“`

—

“`html

【2025年最新版】AIコンテンツの品質を劇的に向上させる!初心者向けチェックリスト完全ガイド

AI(人工知能)を活用した文章作成が急速に普及し、ビジネスの現場で欠かせないツールとなりつつあります。しかし、その手軽さの裏側で、生成されるコンテンツの「品質」をいかに担保するかという新たな課題が浮上しています。特に、AIが事実に基づかない情報を生成する「ハルシネーション(幻覚)」は、企業の信頼性を揺るかしかねない深刻な問題です。 この記事では、AI利用の初心者であるビジネスパーソンの皆さんでも今日から実践できる、AI生成コンテンツの品質を担保するための最新チェックリストを、2025年現在の情報に基づき、分かりやすく徹底解説します。

1. 出典や根拠の明示 – 情報の信頼性を盤石にする

✓ チェック項目: AIが生成した文章中のデータや主張には必ず出典(ソース)を明記し、読者が事実を検証できるようにする。引用のルール(著作権法上の要件)も守る。

AIが生成したコンテンツの信頼性を高める上で最も基本的なステップが、情報の出典や根拠を明確にすることです。AIは膨大なデータから文章を生成しますが、「どの情報源に基づいているか」を自ら示すことは稀です。そのため、私たち人間がその根拠を補い、読者に提示する必要があります。 特に、統計データ、専門的な事実、具体的な数値を記載する際は、出典の明記が不可欠です。

なぜ出典明示が重要なのか?

- 信頼性の向上: 公的機関の統計や権威ある研究機関のレポートなど、信頼性の高い情報源を提示することで、コンテンツ全体の説得力が増します。

- 読者の安心感: 読者は情報がどこから来たのかを知ることで、安心して内容を読み進めることができます。また、自ら元情報を確認することも可能になります。

- 誤情報拡散の防止: 出典が明確であれば、万が一AIが誤った情報を生成しても、ファクトチェックの過程で発見・修正しやすくなります。

実践方法とポイント

具体的な実践方法はシンプルです。「総務省の調査によると、2025年時点の国内インターネット利用率は90%を超える」のように、事実を述べた直後に情報源を記載します。さらに、記事の末尾に参考文献リストとしてURLをまとめて掲載すると、より丁寧な印象を与えます。

また、他者の文章やデータをそのまま使用する場合は、著作権法で定められた「引用」のルールを遵守しなければなりません。 引用部分をカギ括弧やブロッククオート(<blockquote>)で明確に区別し、出所を明記することが法律で義務付けられています。

【引用の基本ルール】 ・引用部分が明確に区別されていること ・出典元が明記されていること ・引用する必要性があること ・内容を改変しないこと

便利な支援ツール

最近では、出典管理を助けるツールも登場しています。例えば、Microsoftの「Copilot」は文章作成中に関連する情報源を提示する機能があり、参考文献リストの作成をサポートします。また、ChatGPTの拡張機能や、情報源を明記しながら回答を生成するAI(例: Perplexity AI)を活用するのも有効な手段です。 ただし、AIが提示した出典情報が常に正しいとは限らないため、最終的には必ず人間の目でリンク先を確認する作業が必要です。

2. 検収者(レビュー担当者)の配置 – 人間の目で品質を保証する

✓ チェック項目: AIが作成したコンテンツをそのまま公開せず、必ず人間によるレビュー(検収)工程を設ける。可能であれば、複数人によるダブルチェック体制を構築する。

AIはあくまで強力な「下書きツール」であり、最終的な品質責任は人間が負うべきです。 AIは文法的な誤りや単純なミスを見つけるのは得意ですが、文脈に応じた細かなニュアンス、ブランドイメージに沿ったトーン&マナー、倫理的な配慮といった点は判断できません。 そのため、AIが生成した文章を人間の検収者がレビューするプロセスは、品質管理の要となります。

なぜ人間のレビューが不可欠なのか?

- 文脈とニュアンスの判断: 読者の感情に寄り添った表現や、企業として発信するにふさわしい言葉遣いになっているかをチェックします。

- 事実確認(ファクトチェック): AIが生成した情報に誤りがないか、前述の出典確認と合わせて検証します。

- 独自性とE-E-A-Tの強化: Googleはコンテンツの品質を評価する基準として「E-E-A-T」(経験・専門性・権威性・信頼性)を重視しています。 AIが生成した一般的な情報に、人間が独自の経験や専門的な知見を加えることで、コンテンツの価値は飛躍的に高まります。

- ブランドイメージの維持: 企業のブランドガイドラインに沿った、一貫性のあるメッセージングになっているかを確認します。

効果的なレビュー体制の構築例

理想的なのは、役割を分担した多段階のチェックフローです。 これにより、チェックの抜け漏れを防ぎ、コンテンツの品質を多角的に高めることができます。

| フェーズ | 担当者 | 主なチェック項目 |

|---|---|---|

| Phase 1: 一次レビュー | コンテンツ作成者 | 誤字脱字、基本的な構成、AI特有の不自然な表現の修正 |

| Phase 2: 専門性・事実確認 | 分野の専門家 or 上長 | 専門用語の正確性、データの裏付け、情報の最新性、E-E-A-Tの観点からの追記・修正 |

| Phase 3: 最終校正 | 編集責任者 or 別部署の担当者 | ブランドトーンとの整合性、読者視点での分かりやすさ、SEO要件の最終確認 |

このような体制が難しい場合でも、「作成者以外の第三者が必ず一度は目を通す」というルールを設けるだけで、品質は大きく向上します。共同編集ツール(例: Googleドキュメント、Shodo)を活用し、修正履歴を残しながらレビューを進めるのも効率的です。

3. 誤情報(AIハルシネーション)の検出と修正ログの活用

✓ チェック項目: AIの出力内容に誤りや根拠のない部分がないか徹底的に検証し、発見した場合は修正すると共に、その内容を「修正ログ」として記録・共有する。

AIのハルシネーションは、AIが学習データに存在しない情報を、あたかも事実であるかのように生成する現象です。 例えば、存在しない判例を引用したり、架空の歴史的事実を語ったりすることがあります。 これらを防ぐには、「AIの回答は間違っている可能性がある」という前提に立ち、厳格な検出プロセスを導入することが不可欠です。

ハルシネーションの検出方法

- 徹底したファクトチェック: 固有名詞、日付、数値、法律名など、検証可能な情報はすべて信頼できる一次情報源(公式サイト、公的文書など)と照合します。

- 複数AIでのクロスチェック: 同じ質問をChatGPT、Gemini、Claudeなど複数の異なるAIに投げかけ、回答を比較します。 全員が一致する回答は信頼性が高い一方、回答が分かれる部分は要注意です。

- 検索拡張生成(RAG)の活用: RAG (Retrieval-Augmented Generation) とは、AIが回答を生成する前に、指定されたデータベースやウェブから関連情報を検索し、その内容に基づいて回答を作成する技術です。 これにより、AIが完全にゼロから情報を「創作」するのを防ぎ、ハルシネーションを大幅に抑制できます。

- 疑わしい表現への注意: 「驚くべきことに」「最新の研究によると」といった、根拠が曖昧で大げさな表現は、ハルシネーションの兆候である可能性があります。

なぜ「修正ログ」が重要なのか?

誤りを発見して修正するだけでなく、その履歴を記録・管理(ログ管理)することが、長期的な品質向上に繋がります。 修正ログとは、「いつ、誰が、どの部分を、なぜ、どのように修正したか」を記録したものです。

- 再発防止: 「このAIモデルは統計データの誤りが多い」「このテーマでは架空の事例を作りやすい」といった、AIの弱点や癖をチームで共有し、今後のプロンプト設計やレビューに活かすことができます。

- 品質管理の可視化: 修正ログを分析することで、「AI生成物の修正率」といった指標を設け、運用プロセスの改善効果を測定できます。

- 教育・ナレッジ共有: 蓄積された修正事例は、新たなレビュー担当者への教育資料や、社内の「AI利用ガイドライン」の具体例として活用できます。

修正ログの管理には、共有のスプレッドシートやプロジェクト管理ツールが役立ちます。WordやGoogleドキュメントの「変更履歴の記録」機能も手軽で効果的です。

4. 全社的な運用ルールの標準化(コンテンツガバナンス)

✓ チェック項目: これまでのチェック項目を盛り込んだ、全社共通の「AIコンテンツ作成ガイドライン」を策定し、定期的に見直し・更新する体制を整える。

個人のスキルに依存するのではなく、組織全体でAIコンテンツの品質を安定させるためには、明確なルール(ガバナンス)の確立が不可欠です。

ガイドラインに含めるべき項目

- AI利用の基本方針: 「AIは補助ツールであり、最終的な文責は人間が負う」といった基本原則を明記します。

- コンテンツ作成フロー: 「企画→AIで草稿作成→一次レビュー→ファクトチェック→最終承認→公開」といった標準的なプロセスと、各段階での責任者を定めます。

- 禁止事項: 機密情報や個人情報の入力を禁止するなど、セキュリティに関するルールを定めます。

- 使用ツール: 会社として推奨するAIツール、ファクトチェックツール、コピペチェックツールなどを指定します。

–品質チェックリスト: 本記事で紹介した「出典の明示」「ハルシネーションの確認」などの項目を具体的なチェックリストとして文書化します。

このガイドラインは一度作って終わりではなく、AI技術の進化や社内での活用事例の蓄積に応じて、四半期に一度など定期的に見直し、アップデートしていくことが重要です。

まとめ

AIはコンテンツ作成の生産性を劇的に向上させる強力な武器ですが、その力を最大限に引き出し、同時にリスクを管理するためには、人間による丁寧な品質管理が不可欠です。AIと人間がそれぞれの強みを活かして協働することで、効率的かつ高品質なコンテンツ制作が可能になります。

今回ご紹介した4つのチェックポイント――①出典の明示、②人間によるレビュー、③誤情報の検出とログ活用、④運用ルールの標準化――を実践することで、AIの「暴走」を防ぎ、読者から真に信頼されるコンテンツを発信し続けることができます。ぜひ、本日の内容を参考に、自社のAI活用プロセスを見直し、より安全で効果的なコンテンツ制作体制を構築してください。