【2025年最新版】その情報、AIに渡して大丈夫?会社のPCで生成AIを使うときの3つの安全ルール

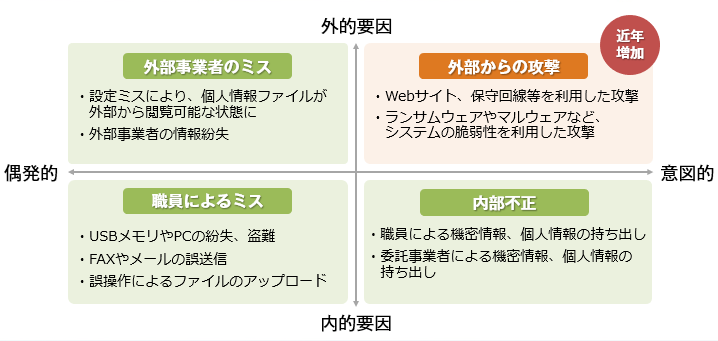

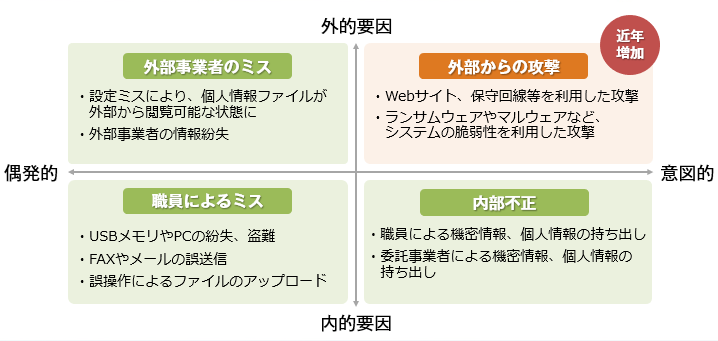

ChatGPTに代表される生成AIは、私たちの働き方を大きく変える可能性を秘めています。メール作成、資料の要約、アイデア出しといった業務を効率化できるため、多くのビジネスパーソンにとって身近なツールになりつつあります。しかし、その一方で「どんな情報を入力していいのか」「会社の機密情報を扱っても大丈夫なのか」といったセキュリティ上の不安を感じている方も多いのではないでしょうか。安易な利用は、思わぬ情報漏洩やコンプライアンス違反につながる危険性があります。

この記事では、生成AIを初めて業務で使う方や、セキュリティに不安を感じる方に向けて、会社のPCで安全に利用するための3つの基本ルールを分かりやすく解説します。便利なツールを正しく理解し、リスクを回避しながら業務に活かすための知識を身につけましょう。

【ルール1】個人情報を絶対に入力しない

最も基本的かつ重要なルールは、自分や他人の個人情報を生成AIに入力しないことです。氏名、住所、電話番号、メールアドレス、マイナンバーカードの情報などは「個人情報保護法」という法律で厳重な管理が義務付けられています。

これらの情報を生成AIに入力すると、そのデータはAIを開発・提供している会社(例えばChatGPTならOpenAI社)のサーバーに送信され、保存される可能性があります。多くの生成AIサービスでは、ユーザーが入力した情報を、AIの性能を向上させるための「学習データ」として利用することが利用規約に記載されています。つまり、一度入力した個人情報が、AIの知識の一部として取り込まれ、将来的に他の誰かへの回答として表示されてしまうリスクがゼロではないのです。

なぜ個人情報の入力が危険なのか?

ポイントは「AIに渡した情報は、自分の手元から離れ、コントロールできなくなる」という点です。インターネット上の外部サーバーにデータが送られた時点で、その情報を完全に削除したり、回収したりすることは非常に困難になります。日本の個人情報保護委員会も、本人の同意なく個人データをAIの学習に利用することは、法律違反にあたる可能性があると注意を促しています。

また、生成AIは時として不正確な情報や、文脈を誤解した回答を生成することがあります。もし、あなたや顧客の個人情報が、誤った情報と結びつけて出力されてしまったら、深刻なプライバシー侵害や信用の失墜につながりかねません。

具体的にNGな情報の例

以下の情報は、絶対に生成AIに入力しないように徹底しましょう。

- 個人を特定できる情報: 氏名、住所、電話番号、メールアドレス、生年月日など

- 従業員や顧客の個人データ: 顧客リスト、人事評価シート、採用応募者の履歴書など

- 認証情報: 会社のシステムにログインするためのIDやパスワード

- 機微情報: マイナンバー、クレジットカード番号、銀行口座情報など

たとえAIサービス側で「入力情報を学習に使わない」という設定(オプトアウト設定)をしていても、万全とは限りません。最初から「個人情報は入力しない」ことを鉄則としましょう。

【ルール2】「社外秘」の情報を入力しない

次に守るべきルールは、会社の機密情報や、外部に公開してはいけない「社外秘」の情報を入力しないことです。これには、社内だけで共有されている資料、開発中の製品情報、取引先との契約内容、独自のプログラムコードなどが含まれます。

これらの情報は、多くの場合、守秘義務契約(NDA: Non-Disclosure Agreement)によって法的に保護されています。もし、こうした情報をChatGPTなど外部のAIサービスに入力してしまうと、その行為自体が「第三者への情報漏洩」とみなされ、契約違反に問われる可能性があります。

NDA(守秘義務契約)違反のリスク

例えば、取引先から「この情報は他言しないでください」と念押しされて共有された資料があるとします。この資料の内容を要約してもらおうとAIに入力した瞬間、あなたは取引先との約束を破り、契約違反を犯したことになるかもしれません。一度インターネットを通じて外部のサーバーに送信された情報は、もはや「秘密」とは言えなくなってしまいます。それにより、会社の信用が傷つくだけでなく、法的な紛争や損害賠償に発展するケースも考えられます。

実際の情報漏洩事例:サムスン電子

2023年4月、韓国の大手企業サムスン電子で、従業員が社内の機密情報であるソースコードなどをChatGPTに入力してしまい、外部に流出した可能性が報じられました。この事態を重く見た同社は、従業員による生成AIの利用を一時的に禁止するという厳しい措置を取りました。この事例は、たとえ悪意がなくても、たった一人の従業員の行動が企業全体を揺るがす大きなリスクになり得ることを示しています。

具体的にNGな機密情報の例

業務で扱う以下の情報は、会社の重要な資産です。絶対に入力しないようにしましょう。

- 未公開のプロジェクト情報: 新製品の企画書、リリース前のサービス仕様書、マーケティング戦略など

- 契約・法務関連の情報: 顧客との契約書、M&Aに関する情報、弁護士との相談内容など

- 技術情報: 自社で開発したソフトウェアのソースコード、独自の製造プロセスに関する情報など

- 財務データ: 公開前の決算情報、詳細な売上データ、予算計画書など

- 営業秘密: 顧客リスト、詳細な営業戦略、価格設定に関する情報など

どんなに便利な機能があっても、守るべき情報は社内の安全な環境に留めておくことが大原則です。

【ルール3】会社のポリシー(方針)に従う

最後のルールは、所属する会社のルールやガイドラインを必ず確認し、それに従うことです。生成AIの急速な普及を受け、多くの企業がその利用に関する社内ポリシーの策定を進めています。

会社の方針は様々で、「業務利用は一切禁止」「申請制で許可された人のみ利用可能」「個人情報や機密情報を入力しないという条件付きで許可」「会社が契約した特定のAIサービスのみ利用可」など、企業のリスク管理の方針によって異なります。まずは、自分の会社がどのようなルールを定めているかを確認することが第一歩です。

許可されたツールだけを使う

特に注意したいのが、利用してよいAIツールの種類です。会社によっては、セキュリティが強化された法人向けプラン(例:ChatGPT Enterprise)を契約し、従業員にはそのツールのみを使うよう指示している場合があります。法人向けプランは、一般の無料版とは異なり、「入力されたデータをAIの学習には利用しない」「通信が暗号化されている」といった安全対策が施されていることが多いからです。

会社が許可していない無料のAIツールを自己判断で使うと、会社のセキュリティポリシーに違反するだけでなく、情報漏洩のリスクを高めることになります。必ず、情報システム部門や上司に確認し、許可された範囲で利用しましょう。

社内ガイドラインの主なポイント

もし自社に生成AI利用のガイドラインがあれば、必ず目を通してください。一般的には、以下のような内容が定められています。

- 入力情報の区分: 何を入力して良くて、何がダメなのか(例:公開情報や一般的な知識はOK、個人・機密情報はNG)

- 生成物の取り扱い: AIが生成した文章やアイデアを、どのように利用してよいか(例:社内での壁打ちのみ、外部への提出は上長の承認が必要など)

- 利用時の義務: AIの回答を鵜呑みにせず、必ず人間が内容の正しさ(ファクトチェック)や、著作権を侵害していないかを確認する義務

不明な点があれば、自己判断で進めずに、必ず担当部署に確認しましょう。「会社として許可された使い方」を徹底することが、あなた自身と会社をリスクから守ることにつながります。

補足:もし誤って機密情報を入力してしまったら?

万が一、誤って入力してはいけない情報をAIに送信してしまった場合は、慌てずに以下の対応を取りましょう。

- チャット履歴を削除する: 多くのAIサービスでは、過去のやり取りを削除する機能があります。まずは該当の会話履歴を削除してください。

- 学習への利用を停止(オプトアウト)する: ChatGPTなどの設定画面で、自分の入力データをAIの学習に利用させない設定に変更します。今後のリスクを低減できます。

- 上司や担当部署へ報告する: 最も重要な対応です。正直に状況を報告し、会社の指示を仰ぎましょう。迅速な報告が、被害を最小限に食い止める鍵となります。

一度インターネット上に出てしまった情報を完全に消し去ることは困難ですが、被害を拡大させないために、誠実な対応を心がけてください。

安全活用のための最終チェックリスト

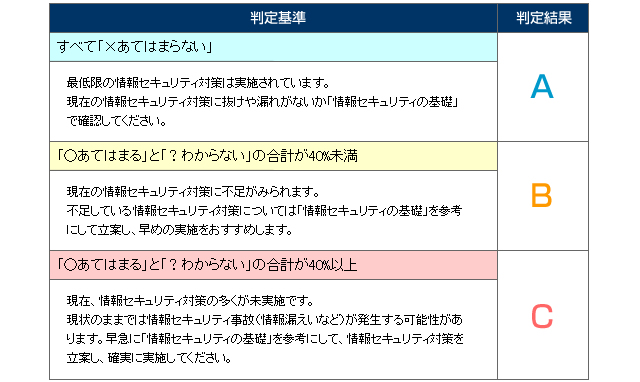

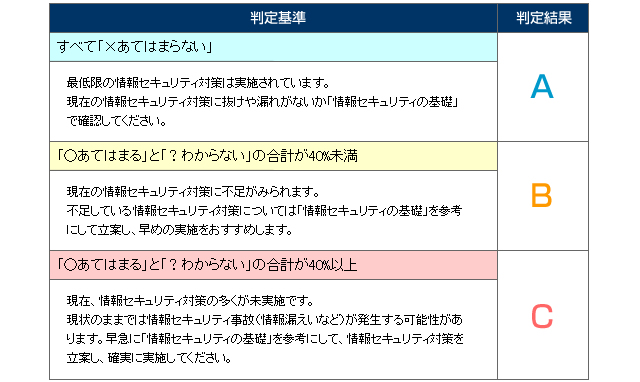

生成AIを利用する前に、一度立ち止まって以下の項目を確認する習慣をつけましょう。

- 入力する内容に、個人情報(氏名、連絡先など)は含まれていないか?

- 入力する内容は、社外秘や他社との秘密保持契約に関わる情報ではないか?

- 今使おうとしているAIツールは、会社から利用を許可されたものか?

- AIが生成した回答を、そのまま鵜呑みにしていないか?(内容の事実確認は必要)

- AIの回答が、他者の著作権やプライバシーを侵害していないか?

- 会社のガイドラインに定められた手順やルールを守っているか?

これらのチェック項目に一つでも「いいえ」や「わからない」があれば、入力を中止し、情報を加工したり、上司に相談したりするなどの慎重な対応が必要です。

まとめ

生成AIは、正しく使えば業務を劇的に効率化してくれる強力なツールです。しかし、その手軽さの裏には、情報漏洩という大きなリスクが潜んでいます。

今回ご紹介した3つの安全ルール、

- 個人情報を入力しない

- 社外秘の情報を入力しない

- 会社のポリシーに従う

を徹底するだけで、リスクの大部分は回避できます。過度に恐れるのではなく、「この情報をAI(外部の第三者)に渡しても本当に大丈夫か?」と一呼吸おいて考える癖をつけることが重要です。

会社のルールを守り、安全な使い方をマスターして、生成AIをあなたの頼れるビジネスパートナーにしていきましょう。

“`

—

### 最終納品用HTML(citationタグ除去済み)

“`html

【2025年最新版】その情報、AIに渡して大丈夫?会社のPCで生成AIを使うときの3つの安全ルール

ChatGPTに代表される生成AIは、私たちの働き方を大きく変える可能性を秘めています。メール作成、資料の要約、アイデア出しといった業務を効率化できるため、多くのビジネスパーソンにとって身近なツールになりつつあります。しかし、その一方で「どんな情報を入力していいのか」「会社の機密情報を扱っても大丈夫なのか」といったセキュリティ上の不安を感じている方も多いのではないでしょうか。安易な利用は、思わぬ情報漏洩やコンプライアンス違反につながる危険性があります。

この記事では、生成AIを初めて業務で使う方や、セキュリティに不安を感じる方に向けて、会社のPCで安全に利用するための3つの基本ルールを分かりやすく解説します。便利なツールを正しく理解し、リスクを回避しながら業務に活かすための知識を身につけましょう。

【ルール1】個人情報を絶対に入力しない

最も基本的かつ重要なルールは、自分や他人の個人情報を生成AIに入力しないことです。氏名、住所、電話番号、メールアドレス、マイナンバーカードの情報などは「個人情報保護法」という法律で厳重な管理が義務付けられています。

これらの情報を生成AIに入力すると、そのデータはAIを開発・提供している会社(例えばChatGPTならOpenAI社)のサーバーに送信され、保存される可能性があります。多くの生成AIサービスでは、ユーザーが入力した情報を、AIの性能を向上させるための「学習データ」として利用することが利用規約に記載されています。つまり、一度入力した個人情報が、AIの知識の一部として取り込まれ、将来的に他の誰かへの回答として表示されてしまうリスクがゼロではないのです。

なぜ個人情報の入力が危険なのか?

ポイントは「AIに渡した情報は、自分の手元から離れ、コントロールできなくなる」という点です。インターネット上の外部サーバーにデータが送られた時点で、その情報を完全に削除したり、回収したりすることは非常に困難になります。日本の個人情報保護委員会も、本人の同意なく個人データをAIの学習に利用することは、法律違反にあたる可能性があると注意を促しています。

また、生成AIは時として不正確な情報や、文脈を誤解した回答を生成することがあります。もし、あなたや顧客の個人情報が、誤った情報と結びつけて出力されてしまったら、深刻なプライバシー侵害や信用の失墜につながりかねません。

具体的にNGな情報の例

以下の情報は、絶対に生成AIに入力しないように徹底しましょう。

- 個人を特定できる情報: 氏名、住所、電話番号、メールアドレス、生年月日など

- 従業員や顧客の個人データ: 顧客リスト、人事評価シート、採用応募者の履歴書など

- 認証情報: 会社のシステムにログインするためのIDやパスワード

- 機微情報: マイナンバー、クレジットカード番号、銀行口座情報など

たとえAIサービス側で「入力情報を学習に使わない」という設定(オプトアウト設定)をしていても、万全とは限りません。最初から「個人情報は入力しない」ことを鉄則としましょう。

【ルール2】「社外秘」の情報を入力しない

次に守るべきルールは、会社の機密情報や、外部に公開してはいけない「社外秘」の情報を入力しないことです。これには、社内だけで共有されている資料、開発中の製品情報、取引先との契約内容、独自のプログラムコードなどが含まれます。

これらの情報は、多くの場合、守秘義務契約(NDA: Non-Disclosure Agreement)によって法的に保護されています。もし、こうした情報をChatGPTなど外部のAIサービスに入力してしまうと、その行為自体が「第三者への情報漏洩」とみなされ、契約違反に問われる可能性があります。

NDA(守秘義務契約)違反のリスク

例えば、取引先から「この情報は他言しないでください」と念押しされて共有された資料があるとします。この資料の内容を要約してもらおうとAIに入力した瞬間、あなたは取引先との約束を破り、契約違反を犯したことになるかもしれません。一度インターネットを通じて外部のサーバーに送信された情報は、もはや「秘密」とは言えなくなってしまいます。それにより、会社の信用が傷つくだけでなく、法的な紛争や損害賠償に発展するケースも考えられます。

実際の情報漏洩事例:サムスン電子

2023年4月、韓国の大手企業サムスン電子で、従業員が社内の機密情報であるソースコードなどをChatGPTに入力してしまい、外部に流出した可能性が報じられました。この事態を重く見た同社は、従業員による生成AIの利用を一時的に禁止するという厳しい措置を取りました。この事例は、たとえ悪意がなくても、たった一人の従業員の行動が企業全体を揺るがす大きなリスクになり得ることを示しています。

具体的にNGな機密情報の例

業務で扱う以下の情報は、会社の重要な資産です。絶対に入力しないようにしましょう。

- 未公開のプロジェクト情報: 新製品の企画書、リリース前のサービス仕様書、マーケティング戦略など

- 契約・法務関連の情報: 顧客との契約書、M&Aに関する情報、弁護士との相談内容など

- 技術情報: 自社で開発したソフトウェアのソースコード、独自の製造プロセスに関する情報など

- 財務データ: 公開前の決算情報、詳細な売上データ、予算計画書など

- 営業秘密: 顧客リスト、詳細な営業戦略、価格設定に関する情報など

どんなに便利な機能があっても、守るべき情報は社内の安全な環境に留めておくことが大原則です。

【ルール3】会社のポリシー(方針)に従う

最後のルールは、所属する会社のルールやガイドラインを必ず確認し、それに従うことです。生成AIの急速な普及を受け、多くの企業がその利用に関する社内ポリシーの策定を進めています。

会社の方針は様々で、「業務利用は一切禁止」「申請制で許可された人のみ利用可能」「個人情報や機密情報を入力しないという条件付きで許可」「会社が契約した特定のAIサービスのみ利用可」など、企業のリスク管理の方針によって異なります。まずは、自分の会社がどのようなルールを定めているかを確認することが第一歩です。

許可されたツールだけを使う

特に注意したいのが、利用してよいAIツールの種類です。会社によっては、セキュリティが強化された法人向けプラン(例:ChatGPT Enterprise)を契約し、従業員にはそのツールのみを使うよう指示している場合があります。法人向けプランは、一般の無料版とは異なり、「入力されたデータをAIの学習には利用しない」「通信が暗号化されている」といった安全対策が施されていることが多いからです。

会社が許可していない無料のAIツールを自己判断で使うと、会社のセキュリティポリシーに違反するだけでなく、情報漏洩のリスクを高めることになります。必ず、情報システム部門や上司に確認し、許可された範囲で利用しましょう。

社内ガイドラインの主なポイント

もし自社に生成AI利用のガイドラインがあれば、必ず目を通してください。一般的には、以下のような内容が定められています。

- 入力情報の区分: 何を入力して良くて、何がダメなのか(例:公開情報や一般的な知識はOK、個人・機密情報はNG)

- 生成物の取り扱い: AIが生成した文章やアイデアを、どのように利用してよいか(例:社内での壁打ちのみ、外部への提出は上長の承認が必要など)

- 利用時の義務: AIの回答を鵜呑みにせず、必ず人間が内容の正しさ(ファクトチェック)や、著作権を侵害していないかを確認する義務

不明な点があれば、自己判断で進めずに、必ず担当部署に確認しましょう。「会社として許可された使い方」を徹底することが、あなた自身と会社をリスクから守ることにつながります。

補足:もし誤って機密情報を入力してしまったら?

万が一、誤って入力してはいけない情報をAIに送信してしまった場合は、慌てずに以下の対応を取りましょう。

- チャット履歴を削除する: 多くのAIサービスでは、過去のやり取りを削除する機能があります。まずは該当の会話履歴を削除してください。

- 学習への利用を停止(オプトアウト)する: ChatGPTなどの設定画面で、自分の入力データをAIの学習に利用させない設定に変更します。今後のリスクを低減できます。

- 上司や担当部署へ報告する: 最も重要な対応です。正直に状況を報告し、会社の指示を仰ぎましょう。迅速な報告が、被害を最小限に食い止める鍵となります。

一度インターネット上に出てしまった情報を完全に消し去ることは困難ですが、被害を拡大させないために、誠実な対応を心がけてください。

安全活用のための最終チェックリスト

生成AIを利用する前に、一度立ち止まって以下の項目を確認する習慣をつけましょう。

- 入力する内容に、個人情報(氏名、連絡先など)は含まれていないか?

- 入力する内容は、社外秘や他社との秘密保持契約に関わる情報ではないか?

- 今使おうとしているAIツールは、会社から利用を許可されたものか?

- AIが生成した回答を、そのまま鵜呑みにしていないか?(内容の事実確認は必要)

- AIの回答が、他者の著作権やプライバシーを侵害していないか?

- 会社のガイドラインに定められた手順やルールを守っているか?

これらのチェック項目に一つでも「いいえ」や「わからない」があれば、入力を中止し、情報を加工したり、上司に相談したりするなどの慎重な対応が必要です。

まとめ

生成AIは、正しく使えば業務を劇的に効率化してくれる強力なツールです。しかし、その手軽さの裏には、情報漏洩という大きなリスクが潜んでいます。

今回ご紹介した3つの安全ルール、

- 個人情報を入力しない

- 社外秘の情報を入力しない

- 会社のポリシーに従う

を徹底するだけで、リスクの大部分は回避できます。過度に恐れるのではなく、「この情報をAI(外部の第三者)に渡しても本当に大丈夫か?」と一呼吸おいて考える癖をつけることが重要です。

会社のルールを守り、安全な使い方をマスターして、生成AIをあなたの頼れるビジネスパートナーにしていきましょう。

“`